Tutorials

インタラクティブなチュートリアルで Weights & Biases の使用を開始しましょう。

基本

以下のチュートリアルでは、機械学習の 実験管理 、モデル評価、ハイパーパラメータチューニング、モデルとデータセットの バージョン管理 など、W&B の基本を説明します。

人気のある ML フレームワーク のチュートリアル

W&B で人気のある ML フレームワーク とライブラリを使用する方法に関するステップバイステップの情報については、以下のチュートリアルを参照してください。

その他のリソース

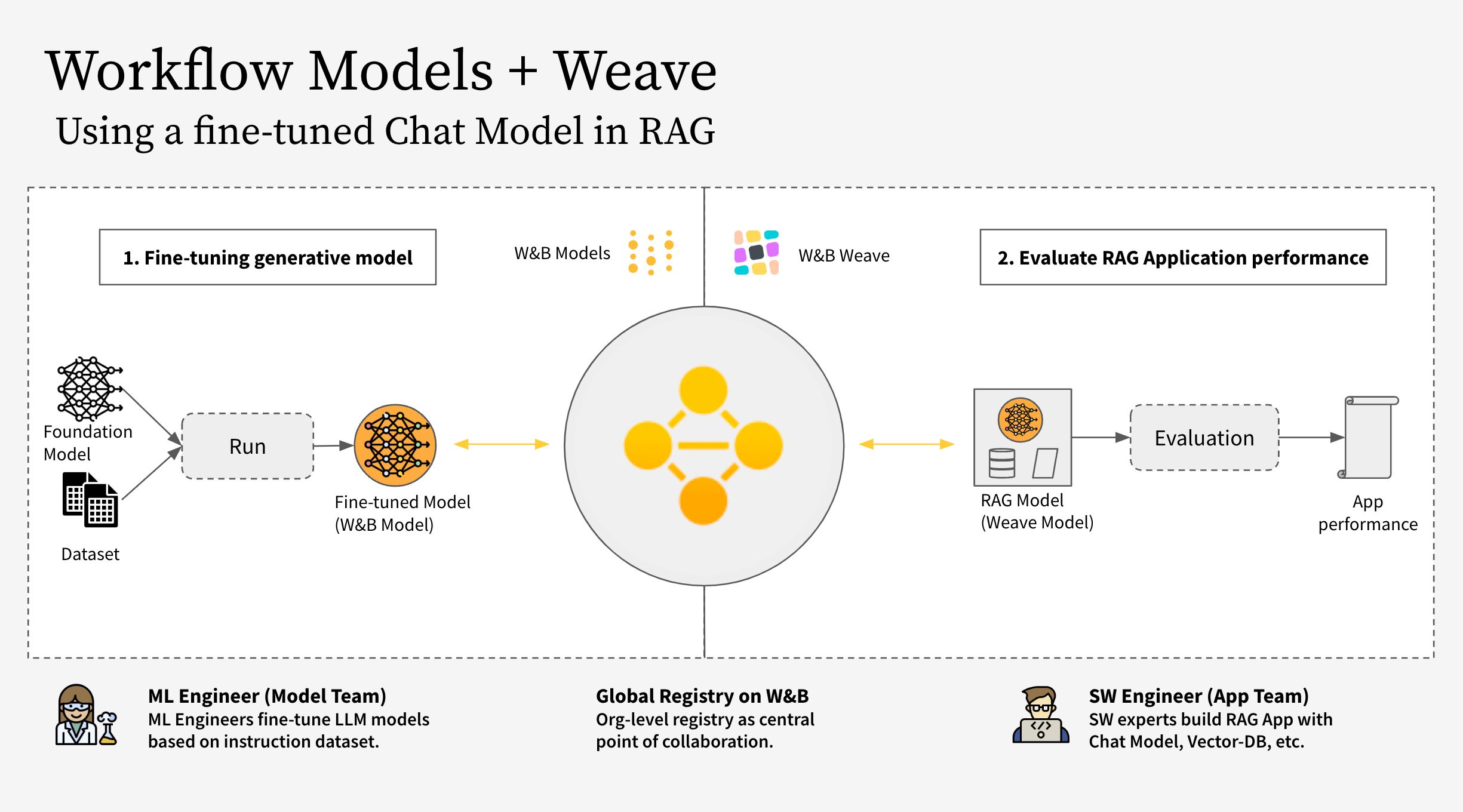

W&B AI Academy にアクセスして、 アプリケーション で LLM をトレーニング、 ファインチューン し、使用する方法を学びます。MLOps および LLMOps ソリューションを実装します。W&B コース で実際の ML の課題に取り組みます。

- 大規模言語モデル (LLM)

- 効果的な MLOps

- W&B Models

1 - Track experiments

W&B を使用して、機械学習 の実験管理、モデル のチェックポイント、チーム とのコラボレーションなどを行います。

この ノートブック では、単純な PyTorch モデル を使用して、機械学習 の 実験 を作成および追跡します。ノートブック の終わりまでに、チーム の他の メンバー と共有およびカスタマイズできるインタラクティブな プロジェクト ダッシュボード が作成されます。ダッシュボード の例はこちら

前提条件

W&B Python SDK をインストールして ログイン します。

# W&B アカウントにログインします

import wandb

import random

import math

# wandb-core を使用します。wandb の新しい バックエンド 用に一時的に使用されます

wandb.require("core")

W&B で 機械学習 の 実験 をシミュレートおよび追跡する

機械学習 の 実験 を作成、追跡、および視覚化します。これを行うには:

- W&B run を初期化し、追跡する ハイパーパラメータ を渡します。

- トレーニング ループ 内で、精度 や 損失 などの メトリクス を ログ に記録します。

import random

import math

# シミュレートされた 5 つの 実験 を起動します

total_runs = 5

for run in range(total_runs):

# 1️. この スクリプト を追跡するために新しい run を開始します

wandb.init(

# この run が ログ に記録される プロジェクト を設定します

project="basic-intro",

# run 名を渡します (そうでない場合は、sunshine-lollypop-10 のようにランダムに割り当てられます)

name=f"experiment_{run}",

# ハイパーパラメータ と run メタデータ を追跡します

config={

"learning_rate": 0.02,

"architecture": "CNN",

"dataset": "CIFAR-100",

"epochs": 10,

})

# この簡単な ブロック は、メトリクス を ログ に記録する トレーニング ループ をシミュレートします

epochs = 10

offset = random.random() / 5

for epoch in range(2, epochs):

acc = 1 - 2 ** -epoch - random.random() / epoch - offset

loss = 2 ** -epoch + random.random() / epoch + offset

# 2️. スクリプト から W&B に メトリクス を ログ に記録します

wandb.log({"acc": acc, "loss": loss})

# run に完了のマークを付けます

wandb.finish()

W&B プロジェクト で 機械学習 がどのように実行されたかを確認します。前の セル から出力された URL リンク をコピーして貼り付けます。URL は、グラフ を表示する ダッシュボード を含む W&B プロジェクト にリダイレクトされます。

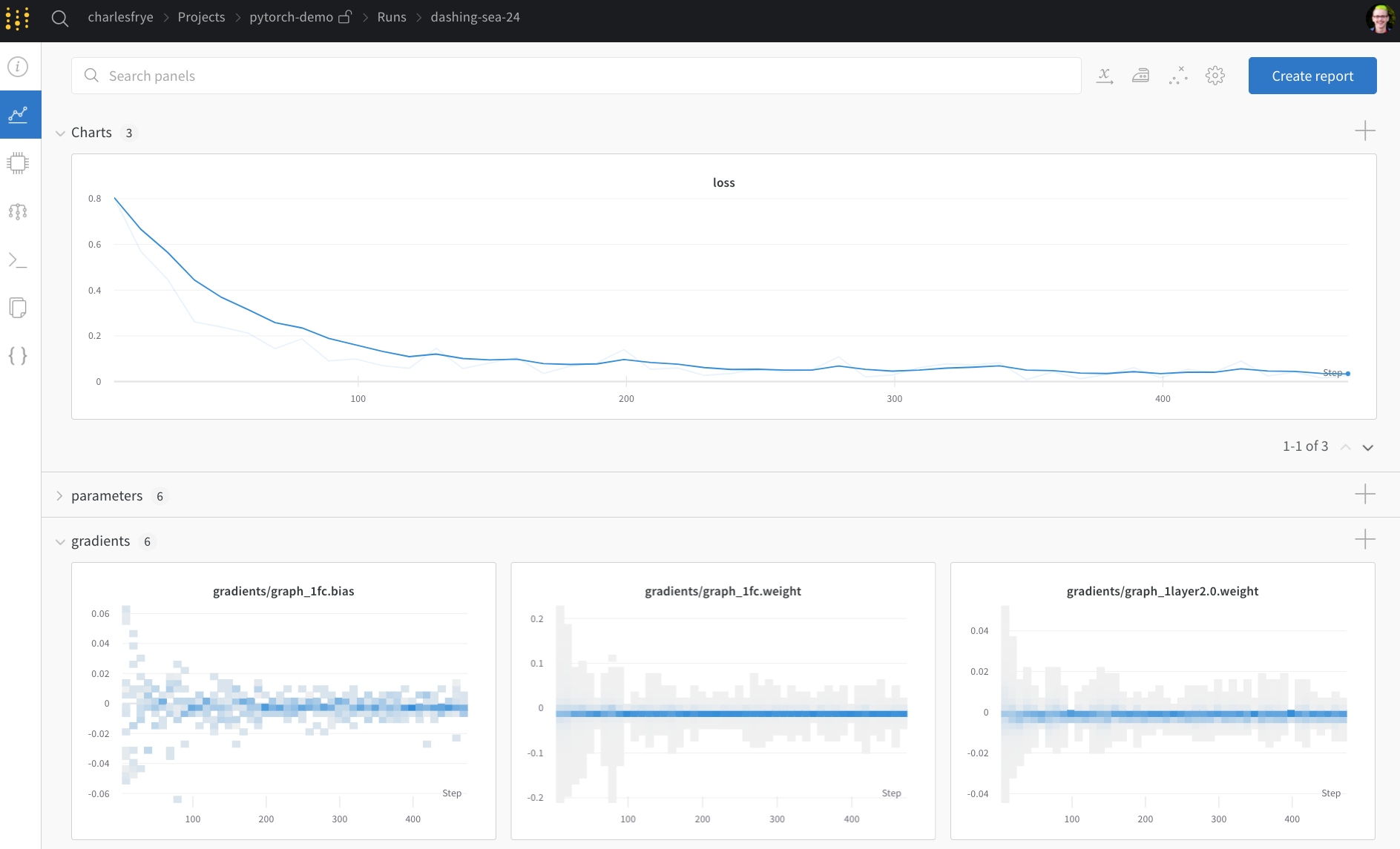

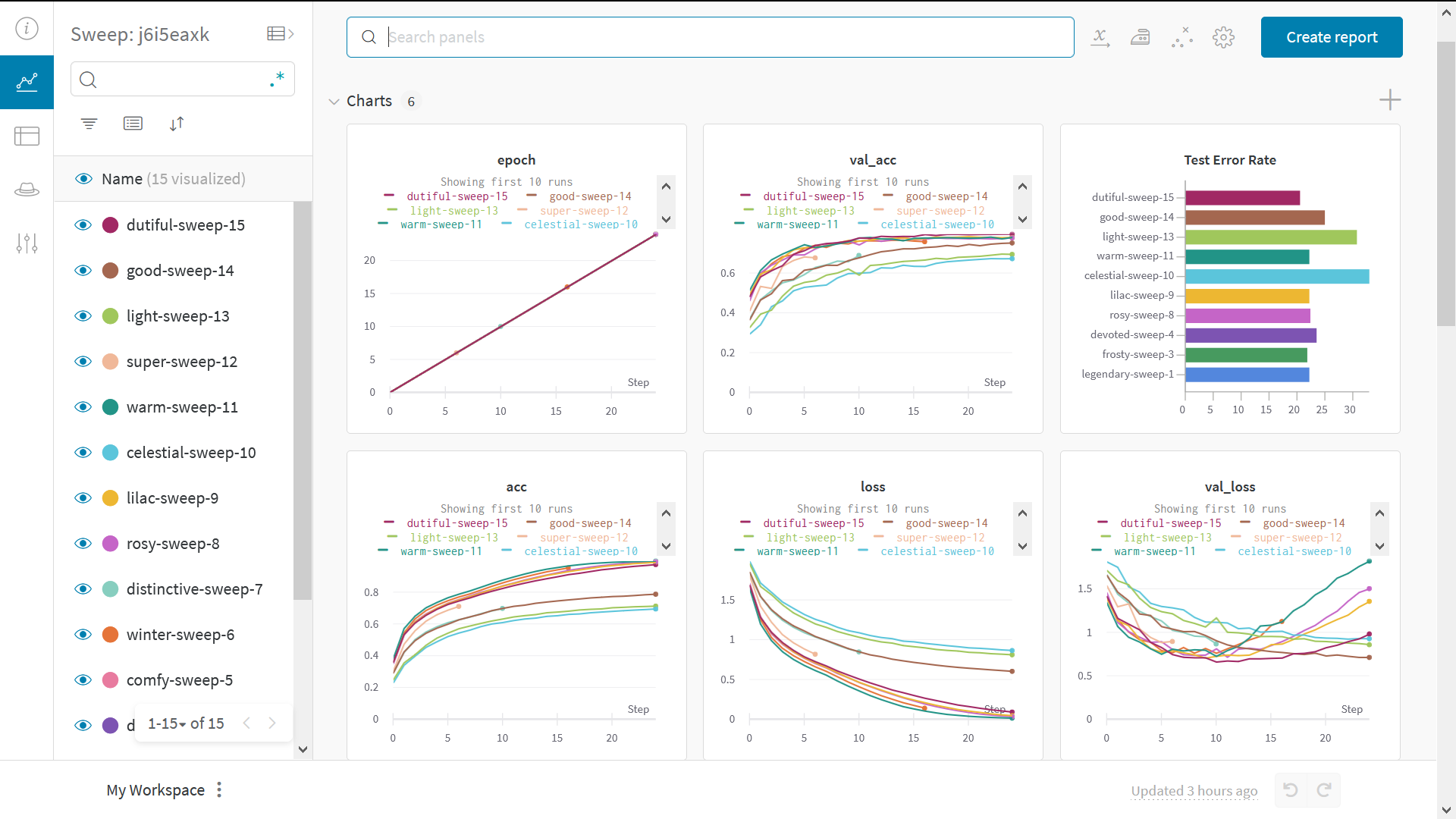

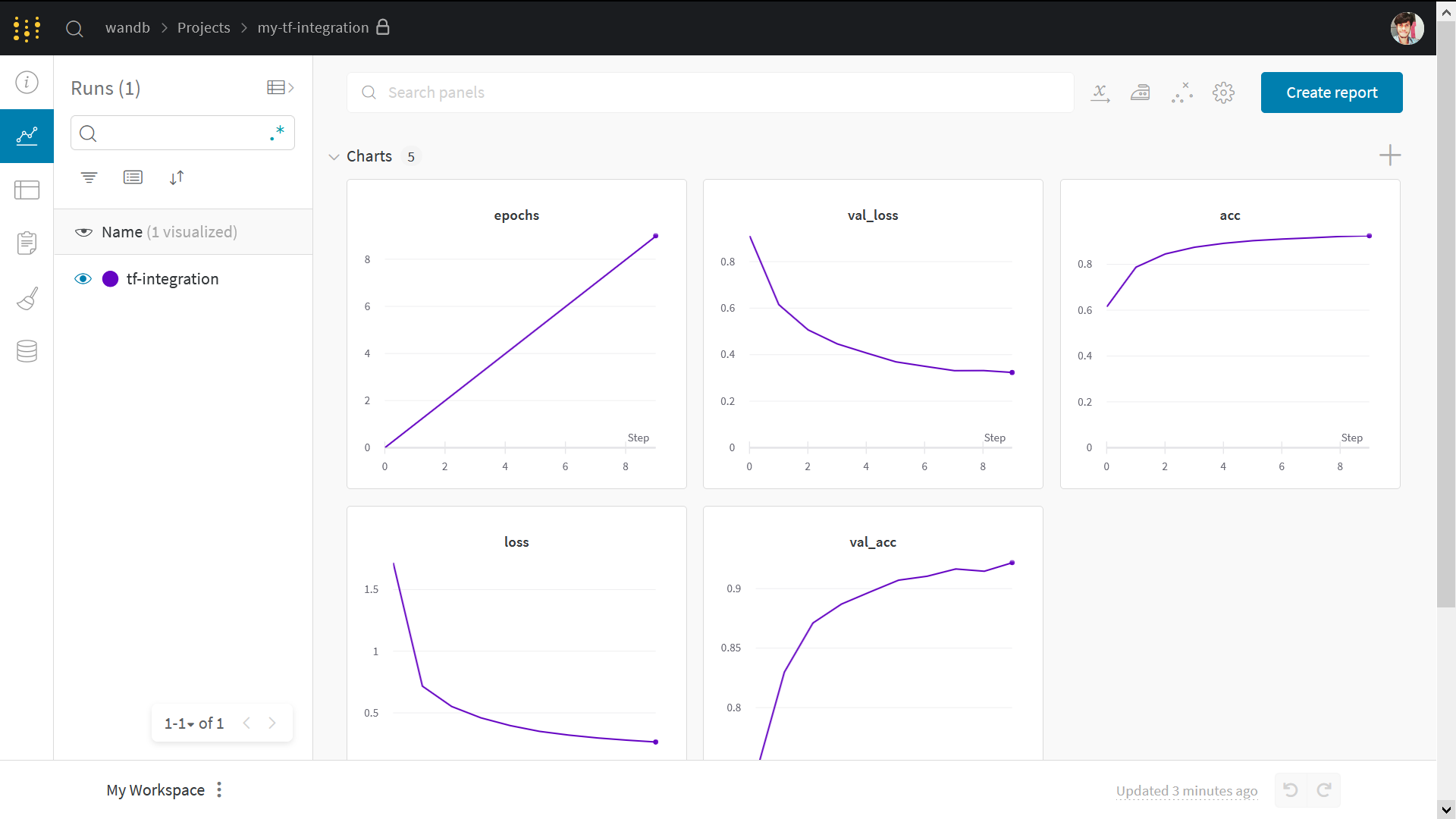

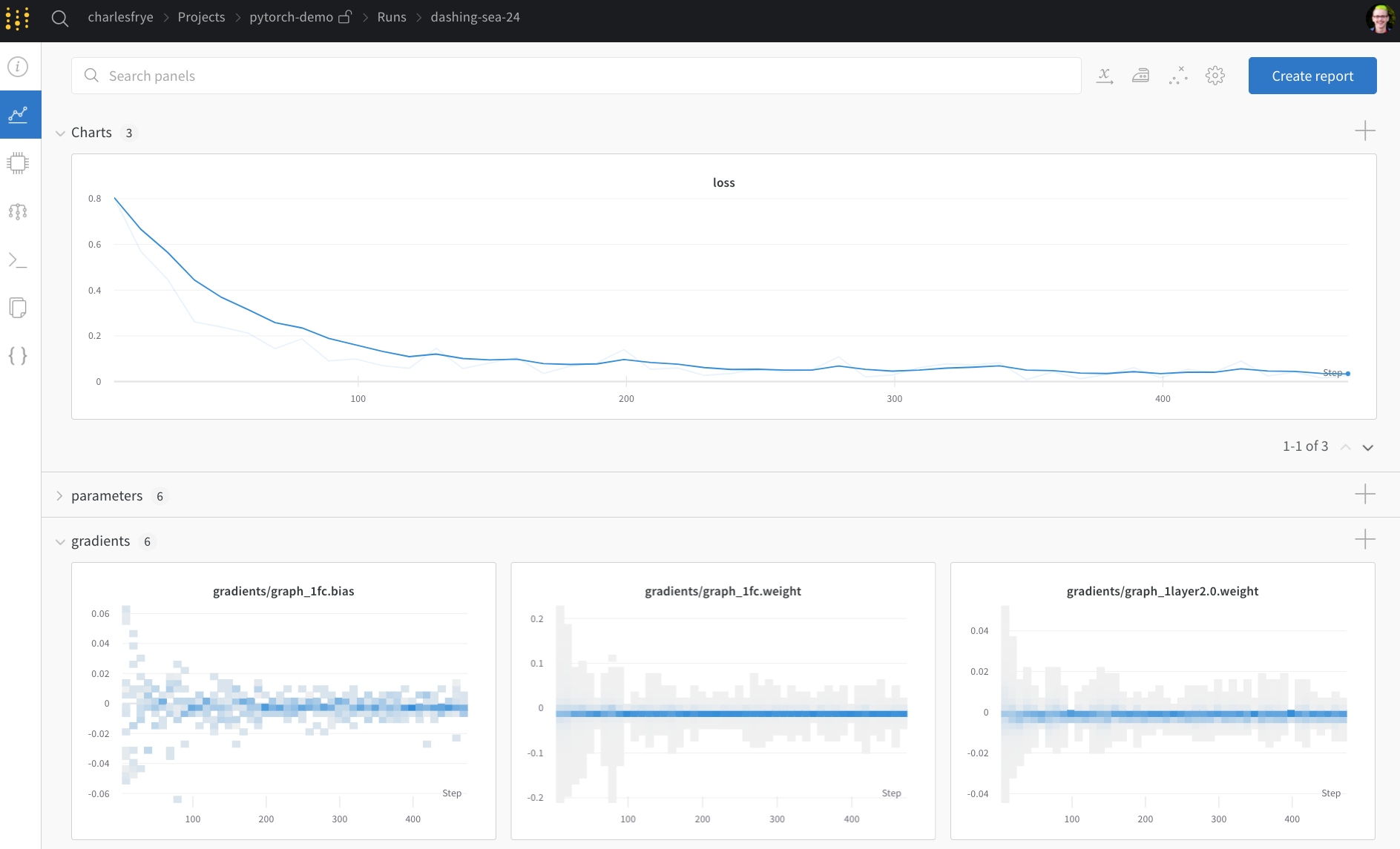

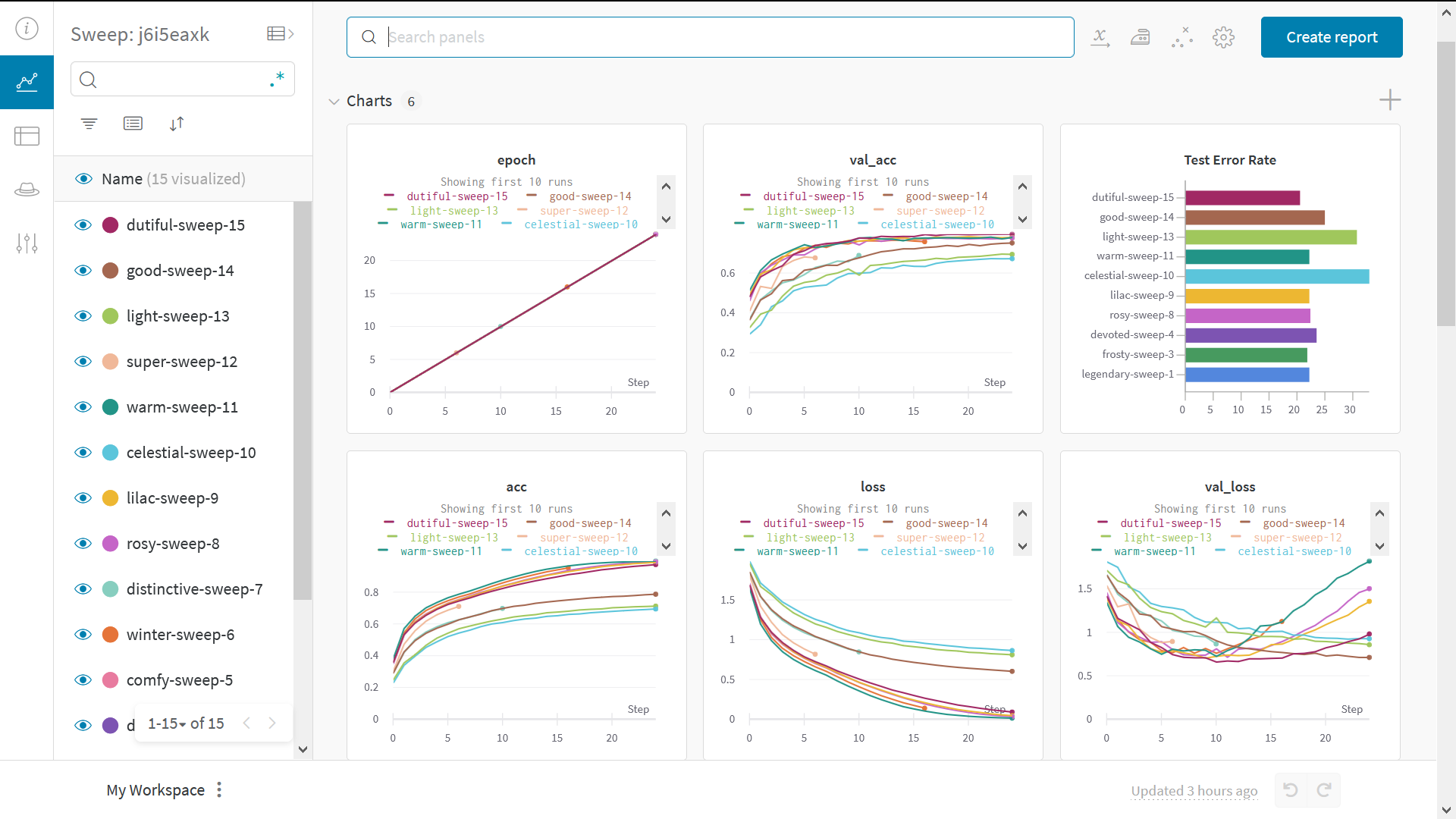

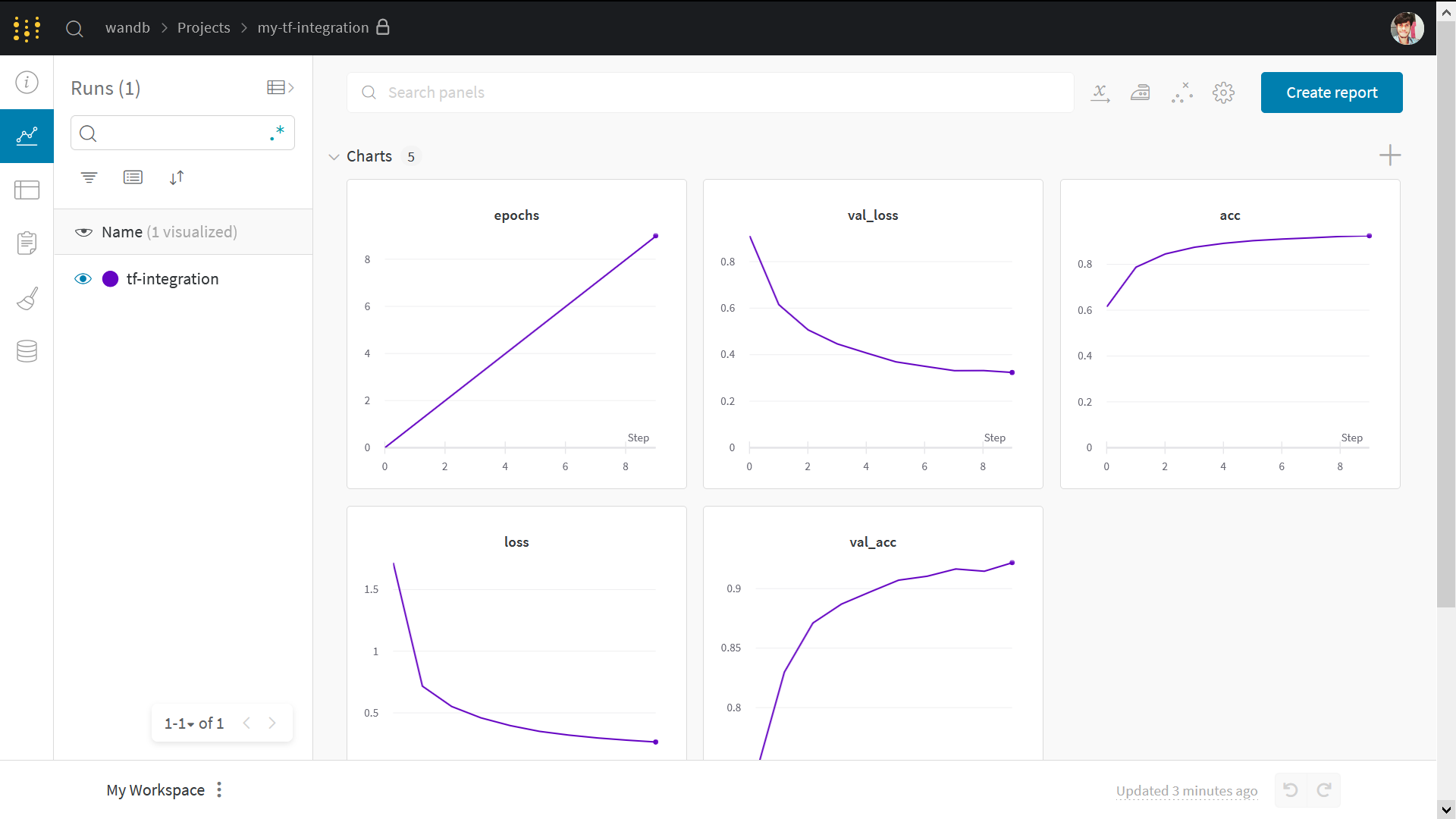

次の画像は、ダッシュボード がどのように見えるかを示しています。

W&B を 疑似 機械学習 トレーニング ループ に統合する方法がわかったので、基本的な PyTorch ニューラルネットワーク を使用して 機械学習 の 実験 を追跡しましょう。次の コード は、組織 内の 他の チーム と共有できる モデル の チェックポイント を W&B にアップロードします。

Pytorch を使用して 機械学習 の 実験 を追跡する

次の コード セル は、単純な MNIST 分類器 を定義してトレーニングします。トレーニング 中に、W&B が URL を出力します。プロジェクト ページ リンク をクリックして、結果 が W&B プロジェクト に ライブ で ストリーミング されるのを確認します。

W&B run は、メトリクス、システム 情報、ハイパーパラメータ、ターミナル 出力 を自動的に ログ に記録し、モデル の 入力 と 出力 を含む インタラクティブな テーブル が表示されます。

PyTorch Dataloader を設定する

次の セル は、機械学習 モデル をトレーニングするために必要な便利な 関数 をいくつか定義しています。関数 自体は W&B 固有ではないため、ここでは詳細には説明しません。forward pass および backward pass トレーニング ループ の定義方法、PyTorch DataLoaders を使用して トレーニング 用の データ を ロードする方法、および torch.nn.Sequential クラス を使用して PyTorch モデル を定義する方法については、PyTorch ドキュメント を参照してください。

# @title

import torch, torchvision

import torch.nn as nn

from torchvision.datasets import MNIST

import torchvision.transforms as T

MNIST.mirrors = [

mirror for mirror in MNIST.mirrors if "http://yann.lecun.com/" not in mirror

]

device = "cuda:0" if torch.cuda.is_available() else "cpu"

def get_dataloader(is_train, batch_size, slice=5):

"トレーニング データローダー を取得します"

full_dataset = MNIST(

root=".", train=is_train, transform=T.ToTensor(), download=True

)

sub_dataset = torch.utils.data.Subset(

full_dataset, indices=range(0, len(full_dataset), slice)

)

loader = torch.utils.data.DataLoader(

dataset=sub_dataset,

batch_size=batch_size,

shuffle=True if is_train else False,

pin_memory=True,

num_workers=2,

)

return loader

def get_model(dropout):

"単純な モデル"

model = nn.Sequential(

nn.Flatten(),

nn.Linear(28 * 28, 256),

nn.BatchNorm1d(256),

nn.ReLU(),

nn.Dropout(dropout),

nn.Linear(256, 10),

).to(device)

return model

def validate_model(model, valid_dl, loss_func, log_images=False, batch_idx=0):

"検証 データセット での モデル の パフォーマンス を計算し、wandb.Table を ログ に記録します"

model.eval()

val_loss = 0.0

with torch.inference_mode():

correct = 0

for i, (images, labels) in enumerate(valid_dl):

images, labels = images.to(device), labels.to(device)

# Forward pass ➡

outputs = model(images)

val_loss += loss_func(outputs, labels) * labels.size(0)

# 精度 を計算して 累積します

_, predicted = torch.max(outputs.data, 1)

correct += (predicted == labels).sum().item()

# 画像 の 1 つの バッチ を ダッシュボード に ログ に記録します (常に同じ batch_idx)。

if i == batch_idx and log_images:

log_image_table(images, predicted, labels, outputs.softmax(dim=1))

return val_loss / len(valid_dl.dataset), correct / len(valid_dl.dataset)

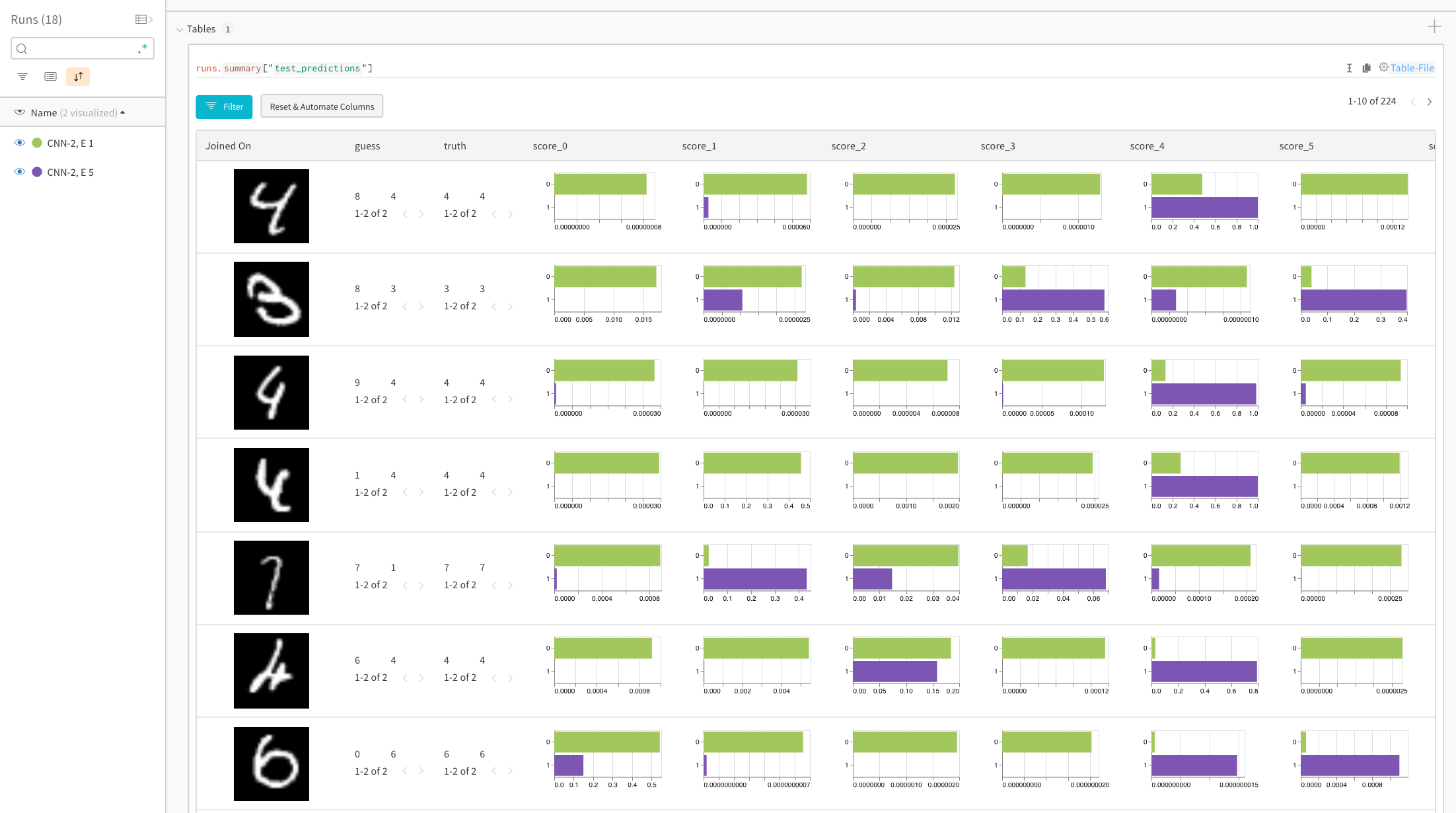

予測値 と 真の 値 を比較する teble を作成する

次の セル は W&B 固有なので、見ていきましょう。

セル では、log_image_table という 関数 を定義します。厳密に言うと、オプション ですが、この 関数 は W&B テーブル オブジェクト を作成します。テーブル オブジェクト を使用して、モデル が 各画像 に対して 予測した内容を示す テーブル を作成します。

より具体的には、各 行 は、モデル に与えられた画像 と、予測値 および 実際の値 (ラベル) で構成されます。

def log_image_table(images, predicted, labels, probs):

"画像、ラベル、および 予測 を含む wandb.Table を ログ に記録します"

# 画像、ラベル、および 予測 を ログ に記録するための wandb テーブル を作成します

table = wandb.Table(

columns=["image", "pred", "target"] + [f"score_{i}" for i in range(10)]

)

for img, pred, targ, prob in zip(

images.to("cpu"), predicted.to("cpu"), labels.to("cpu"), probs.to("cpu")

):

table.add_data(wandb.Image(img[0].numpy() * 255), pred, targ, *prob.numpy())

wandb.log({"predictions_table": table}, commit=False)

モデル をトレーニングし、チェックポイント をアップロードします

次の コード は、モデル の チェックポイント をトレーニングして プロジェクト に保存します。通常どおり モデル の チェックポイント を使用して、トレーニング 中の モデル の パフォーマンス を評価します。

W&B を使用すると、保存された モデル と モデル の チェックポイント を チーム または 組織 の 他の メンバー と簡単に共有することもできます。モデル と モデル の チェックポイント を チーム 外の メンバー と共有する方法については、W&B Registry を参照してください。

# ドロップアウト率 を変えて 3 つの 実験 を起動します

for _ in range(3):

# wandb run を初期化します

wandb.init(

project="pytorch-intro",

config={

"epochs": 5,

"batch_size": 128,

"lr": 1e-3,

"dropout": random.uniform(0.01, 0.80),

},

)

# config をコピーします

config = wandb.config

# データ を取得します

train_dl = get_dataloader(is_train=True, batch_size=config.batch_size)

valid_dl = get_dataloader(is_train=False, batch_size=2 * config.batch_size)

n_steps_per_epoch = math.ceil(len(train_dl.dataset) / config.batch_size)

# 単純な MLP モデル

model = get_model(config.dropout)

# 損失 と オプティマイザー を作成します

loss_func = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=config.lr)

# トレーニング

example_ct = 0

step_ct = 0

for epoch in range(config.epochs):

model.train()

for step, (images, labels) in enumerate(train_dl):

images, labels = images.to(device), labels.to(device)

outputs = model(images)

train_loss = loss_func(outputs, labels)

optimizer.zero_grad()

train_loss.backward()

optimizer.step()

example_ct += len(images)

metrics = {

"train/train_loss": train_loss,

"train/epoch": (step + 1 + (n_steps_per_epoch * epoch))

/ n_steps_per_epoch,

"train/example_ct": example_ct,

}

if step + 1 < n_steps_per_epoch:

# train メトリクス を wandb に ログ に記録します

wandb.log(metrics)

step_ct += 1

val_loss, accuracy = validate_model(

model, valid_dl, loss_func, log_images=(epoch == (config.epochs - 1))

)

# train および 検証 メトリクス を wandb に ログ に記録します

val_metrics = {"val/val_loss": val_loss, "val/val_accuracy": accuracy}

wandb.log({**metrics, **val_metrics})

# モデル の チェックポイント を wandb に保存します

torch.save(model, "my_model.pt")

wandb.log_model(

"./my_model.pt",

"my_mnist_model",

aliases=[f"epoch-{epoch+1}_dropout-{round(wandb.config.dropout, 4)}"],

)

print(

f"Epoch: {epoch+1}, Train Loss: {train_loss:.3f}, Valid Loss: {val_loss:3f}, Accuracy: {accuracy:.2f}"

)

# テスト セット がある場合、これは 概要 メトリクス として ログ に記録する方法です

wandb.summary["test_accuracy"] = 0.8

# wandb run を閉じます

wandb.finish()

これで、W&B を使用して 最初の モデル をトレーニングしました。上記の リンク のいずれかをクリックして、メトリクス を確認し、W&B アプリ UI の Artifacts タブ で保存された モデル の チェックポイント を確認してください

(オプション) W&B Alert を設定する

W&B Alerts を作成して、Python コード から Slack または メール に アラート を送信します。

コード からトリガーされた Slack または メール アラート を初めて送信する場合は、次の 2 つの 手順に従います。

- W&B の ユーザー 設定 で Alerts をオンにします

wandb.alert() を コード に追加します。例:

wandb.alert(title="Low accuracy", text=f"Accuracy is below the acceptable threshold")

次の セル は、wandb.alert の使用方法を示す最小限の例を示しています

# wandb run を開始します

wandb.init(project="pytorch-intro")

# モデル トレーニング ループ をシミュレートします

acc_threshold = 0.3

for training_step in range(1000):

# 精度 の 乱数 を生成します

accuracy = round(random.random() + random.random(), 3)

print(f"Accuracy is: {accuracy}, {acc_threshold}")

# 精度 を wandb に ログ に記録します

wandb.log({"Accuracy": accuracy})

# 精度 が しきい値 を下回る場合は、W&B Alert を起動して run を停止します

if accuracy <= acc_threshold:

# wandb Alert を送信します

wandb.alert(

title="Low Accuracy",

text=f"Accuracy {accuracy} at step {training_step} is below the acceptable theshold, {acc_threshold}",

)

print("Alert triggered")

break

# run に完了のマークを付けます (Jupyter ノートブック で役立ちます)

wandb.finish()

W&B Alerts の 完全な ドキュメント はこちら にあります。

次のステップ

次の チュートリアル では、W&B Sweeps を使用して ハイパーパラメータ の 最適化 を行う方法を学習します。

PyTorch を使用した ハイパーパラメータ sweep

2 - Visualize predictions with tables

ここでは、MNIST データで PyTorch を使用して、トレーニングの過程におけるモデルの予測を追跡、視覚化、および比較する方法について説明します。

学習内容:

- モデルのトレーニングまたは評価中に、メトリクス、画像、テキストなどを

wandb.Table() に ログ 記録する方法

- これらのテーブルの表示、並べ替え、フィルタリング、グループ化、結合、インタラクティブなクエリ、および探索

- 特定の画像、ハイパーパラメータ / モデル バージョン、またはタイム ステップ間でモデルの予測または 結果 を動的に比較します。

Examples

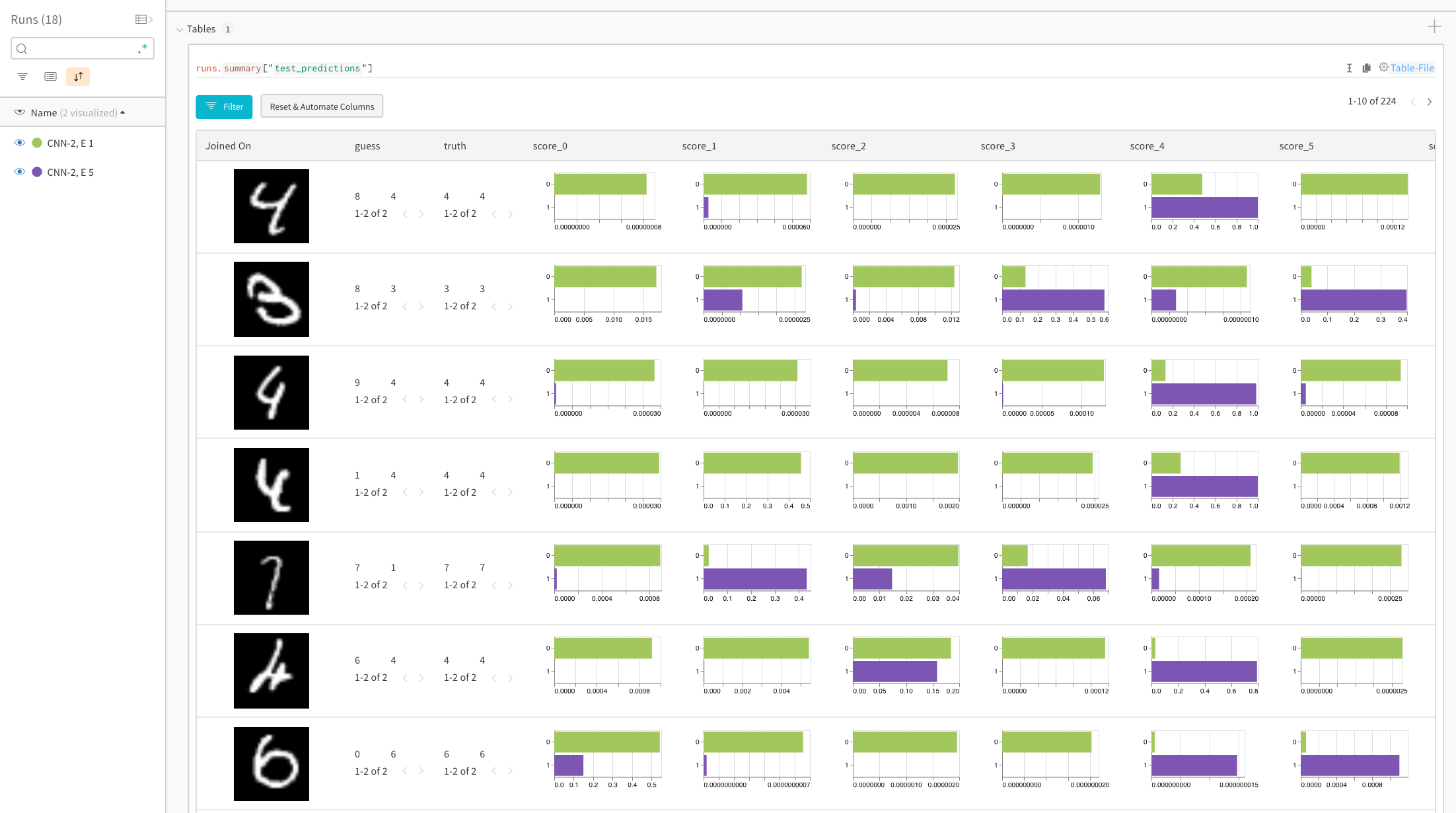

特定の画像の予測スコアを比較する

ライブ 例:トレーニングの 1 エポック後と 5 エポック後の予測を比較する →

ヒストグラムは、2 つのモデル間のクラスごとのスコアを比較します。各ヒストグラムの上部の緑色のバーは、1 エポックのみトレーニングされたモデル「CNN-2, 1 epoch」(ID 0)を表します。下部の紫色のバーは、5 エポックトレーニングされたモデル「CNN-2, 5 epochs」(ID 1)を表します。画像は、モデルが一致しない場合にフィルタリングされます。たとえば、最初の行では、「4」は 1 エポック後、考えられるすべての数字で高いスコアを取得しますが、5 エポック後には、正しいラベルで最も高いスコアを獲得し、残りの部分では非常に低いスコアを獲得します。

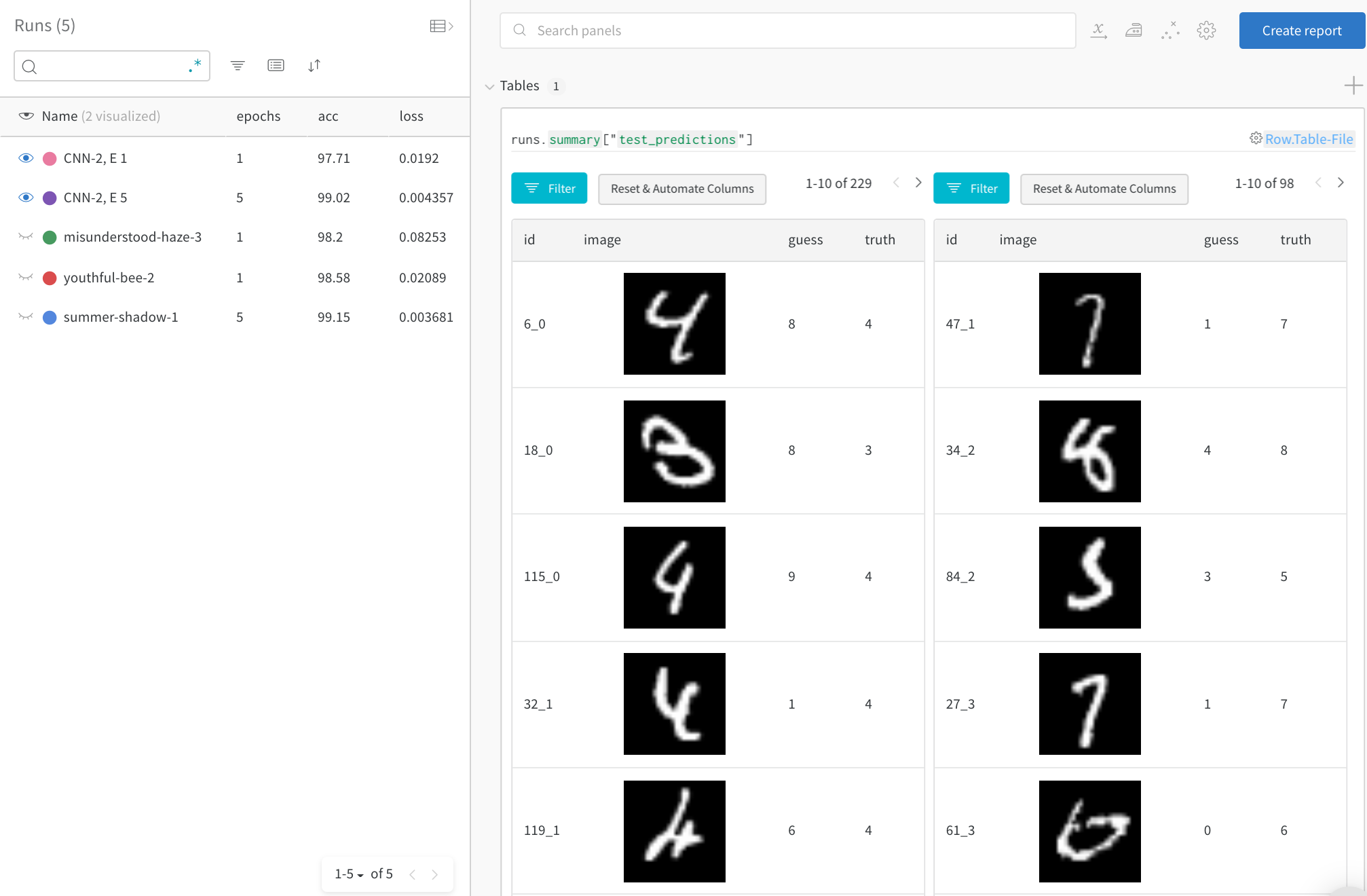

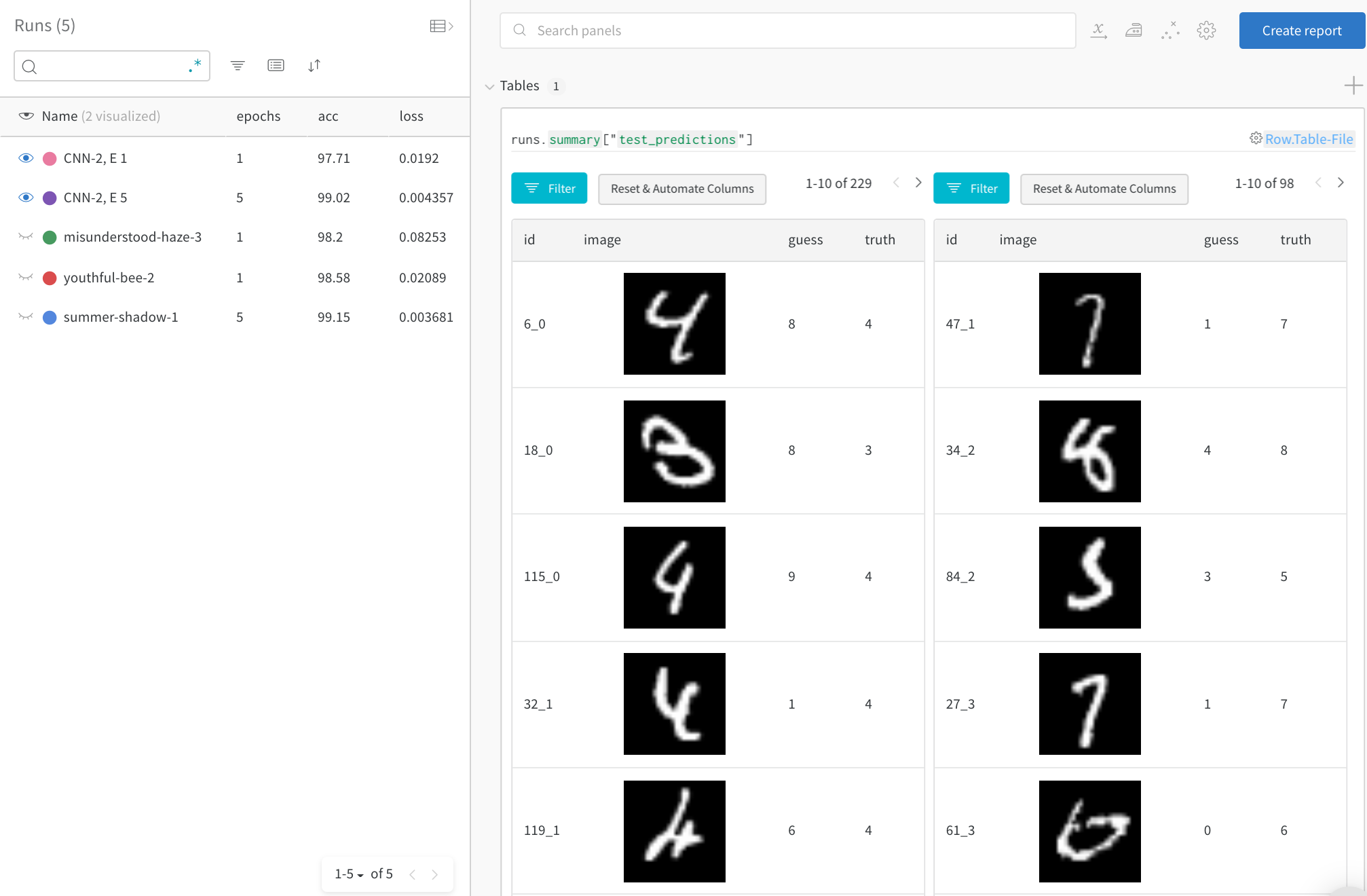

時間の経過に伴う上位のエラーに焦点を当てる

ライブ 例 →

完全なテスト データで、誤った予測(「推測」!=「真実」の行にフィルタリング)を確認します。1 回のトレーニング エポック後には 229 個の間違った推測がありますが、5 エポック後には 98 個しかないことに注意してください。

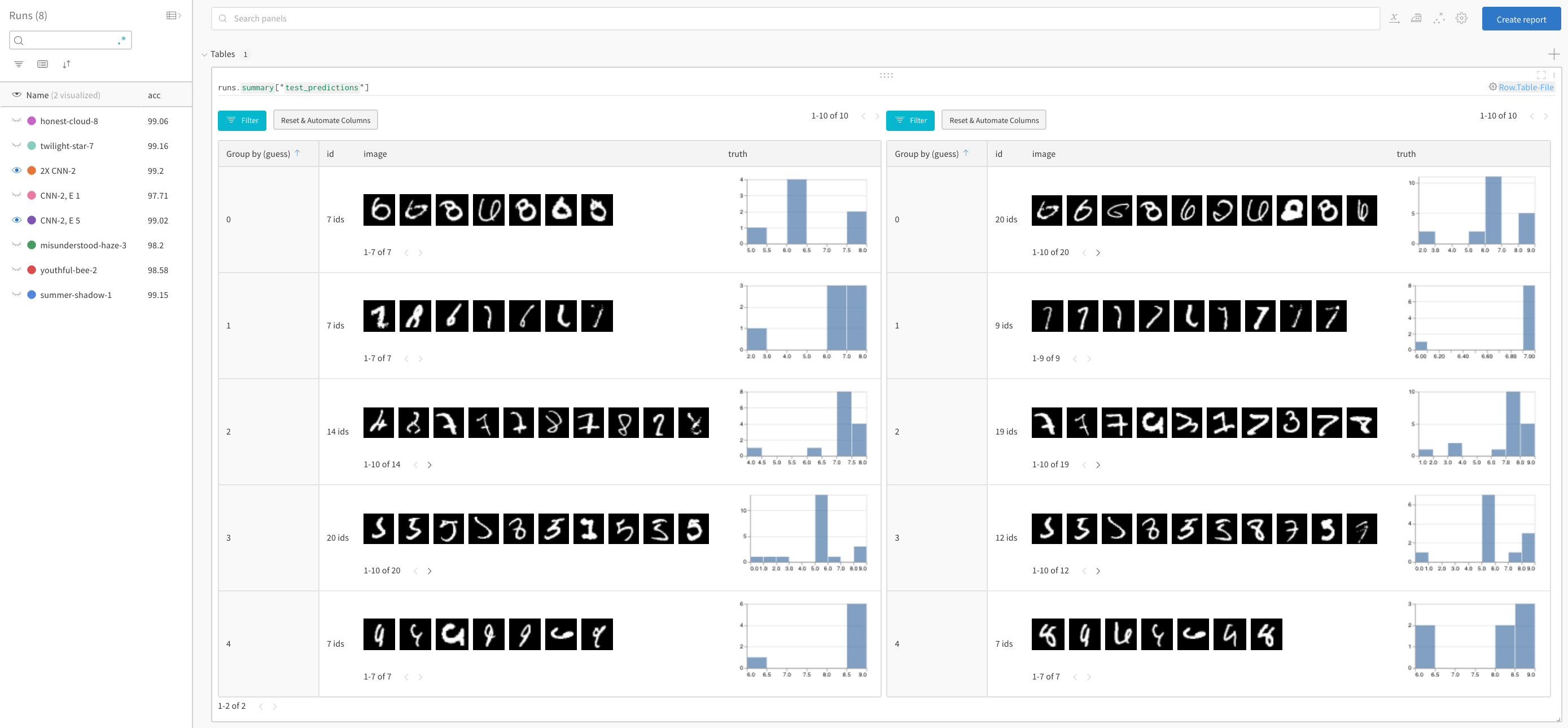

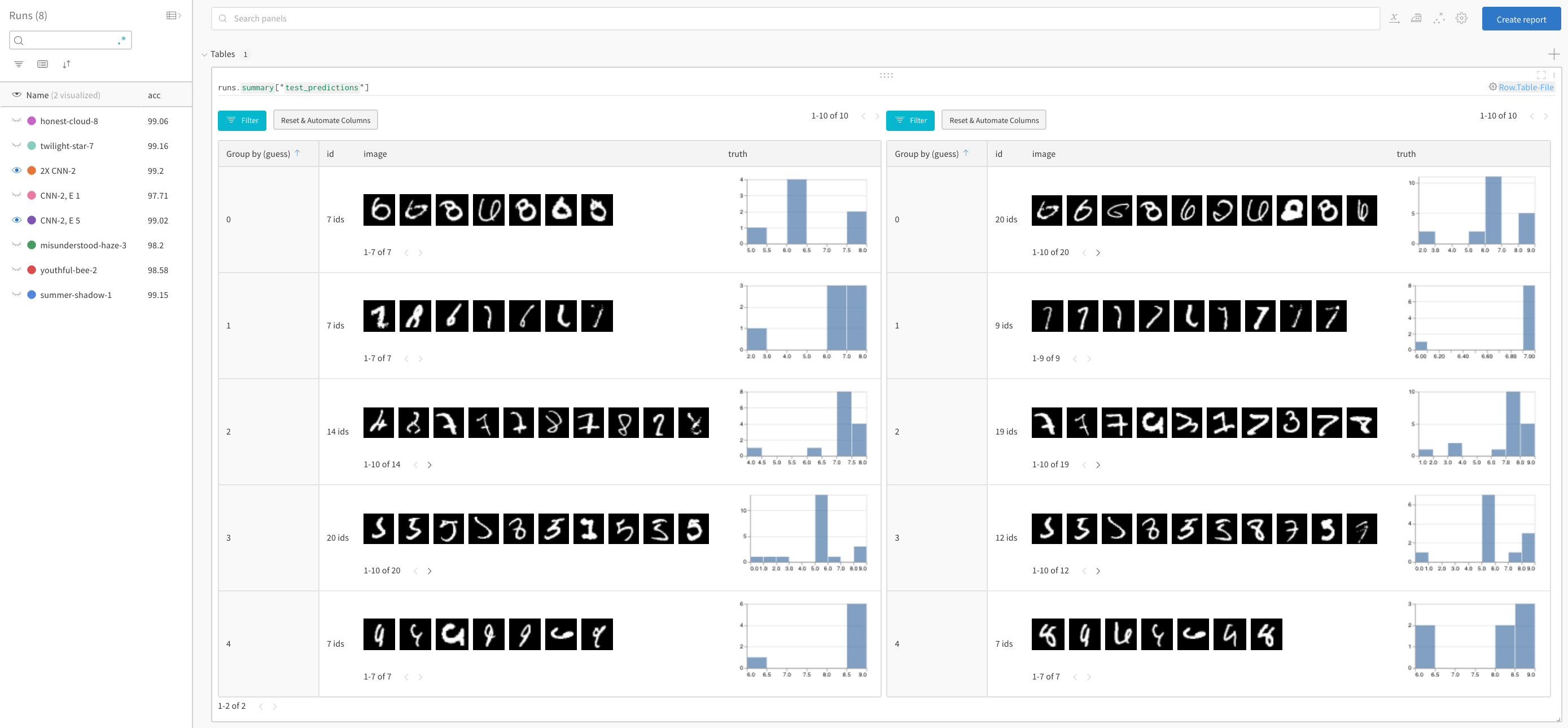

モデル のパフォーマンスを比較し、パターンを見つける

ライブ 例で詳細をご覧ください →

正解を除外し、推測ごとにグループ化して、誤って分類された画像の 例 と、真のラベルの基礎となる分布を、2 つのモデルを並べて表示します。レイヤー サイズと学習率が 2 倍のモデル バリアントが左側にあり、ベースラインが右側にあります。ベースラインでは、推測されたクラスごとにわずかに多くの間違いが発生することに注意してください。

サインアップまたはログイン

サインアップまたはログイン して W&B にアクセスし、ブラウザで 実験 を表示して操作します。

この例では、便利なホスト 環境として Google Colab を使用していますが、どこからでも独自のトレーニング スクリプト を実行し、W&B の 実験管理 ツール で メトリクス を視覚化できます。

アカウントに ログ インします。

import wandb

wandb.login()

WANDB_PROJECT = "mnist-viz"

0. セットアップ

依存関係をインストールし、MNIST をダウンロードし、PyTorch を使用してトレーニング データセット と テストデータセット を作成します。

import torch

import torch.nn as nn

import torchvision

import torchvision.transforms as T

import torch.nn.functional as F

device = "cuda:0" if torch.cuda.is_available() else "cpu"

# トレーニングデータローダーを作成します

def get_dataloader(is_train, batch_size, slice=5):

"トレーニングデータローダーを取得します"

ds = torchvision.datasets.MNIST(root=".", train=is_train, transform=T.ToTensor(), download=True)

loader = torch.utils.data.DataLoader(dataset=ds,

batch_size=batch_size,

shuffle=True if is_train else False,

pin_memory=True, num_workers=2)

return loader

1. モデル と トレーニング スケジュールを定義する

- 実行する エポック 数を設定します。各 エポック は トレーニング ステップと検証 (テスト) ステップで構成されます。オプションで、テスト ステップごとに ログ に記録するデータ量を構成します。ここでは、デモを簡素化するために、視覚化するバッチ数とバッチあたりの画像数が少なく設定されています。

- ( pytorch-tutorial コードに従って) シンプルな畳み込み ニューラルネットワーク を定義します。

- PyTorch を使用してトレーニング セット と テスト セット にロードします。

# 実行するエポック数

# 各エポックにはトレーニングステップとテストステップが含まれるため、これにより、

# ログに記録するテスト予測のテーブル数が設定されます

EPOCHS = 1

# 各テストステップのテストデータからログに記録するバッチ数

# (デモを簡素化するためにデフォルトでは低く設定されています)

NUM_BATCHES_TO_LOG = 10 #79

# テストバッチごとにログに記録する画像数

# (デモを簡素化するためにデフォルトでは低く設定されています)

NUM_IMAGES_PER_BATCH = 32 #128

# トレーニング構成とハイパーパラメータ

NUM_CLASSES = 10

BATCH_SIZE = 32

LEARNING_RATE = 0.001

L1_SIZE = 32

L2_SIZE = 64

# これを変更すると、隣接するレイヤーの形状を変更する必要がある場合があります

CONV_KERNEL_SIZE = 5

# 2層の畳み込みニューラルネットワークを定義します

class ConvNet(nn.Module):

def __init__(self, num_classes=10):

super(ConvNet, self).__init__()

self.layer1 = nn.Sequential(

nn.Conv2d(1, L1_SIZE, CONV_KERNEL_SIZE, stride=1, padding=2),

nn.BatchNorm2d(L1_SIZE),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2))

self.layer2 = nn.Sequential(

nn.Conv2d(L1_SIZE, L2_SIZE, CONV_KERNEL_SIZE, stride=1, padding=2),

nn.BatchNorm2d(L2_SIZE),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2))

self.fc = nn.Linear(7*7*L2_SIZE, NUM_CLASSES)

self.softmax = nn.Softmax(NUM_CLASSES)

def forward(self, x):

# 特定のレイヤーの形状を確認するには、以下をコメント解除してください。

#print("x: ", x.size())

out = self.layer1(x)

out = self.layer2(out)

out = out.reshape(out.size(0), -1)

out = self.fc(out)

return out

train_loader = get_dataloader(is_train=True, batch_size=BATCH_SIZE)

test_loader = get_dataloader(is_train=False, batch_size=2*BATCH_SIZE)

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

2. トレーニング を実行し、テスト予測を ログ に記録する

エポック ごとに、トレーニング ステップとテスト ステップを実行します。各テスト ステップで、テスト予測を格納する wandb.Table() を作成します。これらは、ブラウザで視覚化したり、動的にクエリしたり、並べて比較したりできます。

# W&B: このモデルのトレーニングを追跡するために、新しい run を初期化します

wandb.init(project="table-quickstart")

# W&B: config を使用してハイパーパラメータをログに記録します

cfg = wandb.config

cfg.update({"epochs" : EPOCHS, "batch_size": BATCH_SIZE, "lr" : LEARNING_RATE,

"l1_size" : L1_SIZE, "l2_size": L2_SIZE,

"conv_kernel" : CONV_KERNEL_SIZE,

"img_count" : min(10000, NUM_IMAGES_PER_BATCH*NUM_BATCHES_TO_LOG)})

# モデル、損失、およびオプティマイザーを定義します

model = ConvNet(NUM_CLASSES).to(device)

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=LEARNING_RATE)

# テスト画像のバッチの予測をログに記録するための便利な関数

def log_test_predictions(images, labels, outputs, predicted, test_table, log_counter):

# すべてのクラスの信頼性スコアを取得します

scores = F.softmax(outputs.data, dim=1)

log_scores = scores.cpu().numpy()

log_images = images.cpu().numpy()

log_labels = labels.cpu().numpy()

log_preds = predicted.cpu().numpy()

# 画像の順序に基づいて ID を追加します

_id = 0

for i, l, p, s in zip(log_images, log_labels, log_preds, log_scores):

# 必要な情報をデータテーブルに追加します。

# ID、画像ピクセル、モデルの推測、真のラベル、すべてのクラスのスコア

img_id = str(_id) + "_" + str(log_counter)

test_table.add_data(img_id, wandb.Image(i), p, l, *s)

_id += 1

if _id == NUM_IMAGES_PER_BATCH:

break

# モデルをトレーニングします

total_step = len(train_loader)

for epoch in range(EPOCHS):

# トレーニングステップ

for i, (images, labels) in enumerate(train_loader):

images = images.to(device)

labels = labels.to(device)

# forward pass

outputs = model(images)

loss = criterion(outputs, labels)

# backward と最適化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# W&B: トレーニングステップ全体の損失をログに記録します。UI にライブで視覚化されます

wandb.log({"loss" : loss})

if (i+1) % 100 == 0:

print ('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}'

.format(epoch+1, EPOCHS, i+1, total_step, loss.item()))

# W&B: 各テストステップの予測を保存するための Table を作成します

columns=["id", "image", "guess", "truth"]

for digit in range(10):

columns.append("score_" + str(digit))

test_table = wandb.Table(columns=columns)

# モデルをテストします

model.eval()

log_counter = 0

with torch.no_grad():

correct = 0

total = 0

for images, labels in test_loader:

images = images.to(device)

labels = labels.to(device)

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

if log_counter < NUM_BATCHES_TO_LOG:

log_test_predictions(images, labels, outputs, predicted, test_table, log_counter)

log_counter += 1

total += labels.size(0)

correct += (predicted == labels).sum().item()

acc = 100 * correct / total

# W&B: UI で視覚化するために、トレーニングエポック全体の精度をログに記録します

wandb.log({"epoch" : epoch, "acc" : acc})

print('Test Accuracy of the model on the 10000 test images: {} %'.format(acc))

# W&B: 予測テーブルを wandb にログに記録します

wandb.log({"test_predictions" : test_table})

# W&B: run を完了としてマークします (マルチセル ノートブック に役立ちます)

wandb.finish()

次は何ですか?

次のチュートリアルでは、W&B Sweeps を使用してハイパーパラメータを最適化する方法 を学習します。

3 - Tune hyperparameters with sweeps

望ましいメトリクス(モデルの精度など)を満たす機械学習モデルを見つけることは、通常、複数の反復を必要とする冗長な作業です。さらに悪いことに、特定のトレーニング run にどの ハイパーパラメーター の組み合わせを使用するか不明確な場合があります。

W&B Sweeps を使用すると、学習率、 バッチサイズ 、隠れ層の数、 オプティマイザー の種類など、 ハイパーパラメーター の値の組み合わせを自動的に検索するための、組織化され効率的な方法を作成し、目的のメトリクスに基づいてモデルを最適化する値を見つけることができます。

このチュートリアルでは、W&B PyTorch インテグレーションを使用して ハイパーパラメーター 探索を作成します。ビデオチュートリアルをご覧ください。

Sweeps:概要

Weights & Biases で ハイパーパラメーター sweep を実行するのは非常に簡単です。簡単な3つのステップがあります。

-

sweep を定義する: 検索する パラメータ 、検索戦略、最適化 メトリクス などを指定する 辞書 または YAML ファイル を作成することにより、これを行います。

-

sweep を初期化する: 1行の コード で sweep を初期化し、sweep 設定の 辞書 を渡します。

sweep_id = wandb.sweep(sweep_config)

-

sweep agent を実行する: 1行の コード でも実行でき、wandb.agent() を呼び出し、実行する sweep_id と、モデル アーキテクチャー を定義してトレーニング する関数を渡します。

wandb.agent(sweep_id, function=train)

始める前に

W&B をインストールし、W&B Python SDK を ノートブック にインポートします。

!pip install でインストール:

!pip install wandb -Uq

- W&B をインポート:

import wandb

- W&B にログインし、プロンプトが表示されたら APIキー を入力します。

wandb.login()

ステップ1️:sweep を定義する

W&B Sweep は、多数の ハイパーパラメーター 値を試すための戦略と、それらを評価する コード を組み合わせたものです。

sweep を開始する前に、 sweep 設定 で sweep 戦略を定義する必要があります。

Jupyter Notebook で sweep を開始する場合、sweep 用に作成する sweep 設定は、ネストされた 辞書 にする必要があります。

コマンドライン 内で sweep を実行する場合は、YAML ファイル で sweep 設定を指定する必要があります。

検索方法を選択

まず、設定 辞書 内で ハイパーパラメーター 検索方法を指定します。グリッド、 ランダム 検索、 ベイズ探索 の3つの ハイパーパラメーター 検索戦略から選択できます。

このチュートリアルでは、 ランダム 検索を使用します。 ノートブック 内で、 辞書 を作成し、method キーに random を指定します。

sweep_config = {

'method': 'random'

}

最適化する メトリクス を指定します。 ランダム 検索方法を使用する sweep の メトリクス と目標を指定する必要はありません。ただし、後で参照できるように、sweep の目標を追跡することをお勧めします。

metric = {

'name': 'loss',

'goal': 'minimize'

}

sweep_config['metric'] = metric

検索する ハイパーパラメーター を指定する

これで、sweep 設定で検索方法が指定されたので、検索する ハイパーパラメーター を指定します。

これを行うには、1つ以上の ハイパーパラメーター 名を parameter キーに指定し、value キーに1つ以上の ハイパーパラメーター 値を指定します。

特定の ハイパーパラメーター で検索する値は、調査している ハイパーパラメーター の種類によって異なります。

たとえば、機械学習 オプティマイザー を選択する場合は、Adam オプティマイザー や確率的勾配降下など、1つ以上の有限 オプティマイザー 名を指定する必要があります。

parameters_dict = {

'optimizer': {

'values': ['adam', 'sgd']

},

'fc_layer_size': {

'values': [128, 256, 512]

},

'dropout': {

'values': [0.3, 0.4, 0.5]

},

}

sweep_config['parameters'] = parameters_dict

ハイパーパラメーター を追跡したいが、その値を変更したくない場合があります。この場合、 ハイパーパラメーター を sweep 設定に追加し、使用する正確な値を指定します。たとえば、次の コード セルでは、epochs が1に設定されています。

parameters_dict.update({

'epochs': {

'value': 1}

})

random 検索の場合、

パラメータ のすべての values は、特定の run で選択される可能性が等しくなります。

または、

名前付きの distribution と、その パラメータ (normal 分布の平均 mu や標準偏差 sigma など)を指定できます。

parameters_dict.update({

'learning_rate': {

# 0〜0.1のフラットな分布

'distribution': 'uniform',

'min': 0,

'max': 0.1

},

'batch_size': {

# 32〜256の整数

# 対数が均等に分布

'distribution': 'q_log_uniform_values',

'q': 8,

'min': 32,

'max': 256,

}

})

完了すると、sweep_config はネストされた 辞書 になります。

これは、試してみたい parameters と、それらを試すために使用する method を正確に指定します。

sweep 設定がどのように見えるかを見てみましょう。

import pprint

pprint.pprint(sweep_config)

設定オプションの完全なリストについては、sweep 設定オプション を参照してください。

無限のオプションを持つ可能性のある ハイパーパラメーター の場合、

通常、いくつかの選択された values を試してみるのが理にかなっています。たとえば、前の sweep 設定には、layer_size および dropout パラメータ キーに指定された有限値のリストがあります。

ステップ2️:Sweep を初期化する

検索戦略を定義したら、それを実装するためのものをセットアップします。

W&B は、Sweep Controller を使用して、 クラウド 上またはローカルで1つ以上のマシンにわたって sweep を管理します。このチュートリアルでは、W&B によって管理される sweep コントローラ を使用します。

sweep コントローラ が sweep を管理している間、実際に sweep を実行するコンポーネントは sweep agent と呼ばれます。

デフォルトでは、 sweep コントローラ コンポーネントは W&B の サーバー 上で開始され、 sweep を作成するコンポーネントである sweep agent はローカルマシンでアクティブ化されます。

ノートブック 内では、wandb.sweep メソッドを使用して sweep コントローラ をアクティブ化できます。以前に定義した sweep 設定 辞書 を sweep_config フィールドに渡します。

sweep_id = wandb.sweep(sweep_config, project="pytorch-sweeps-demo")

wandb.sweep 関数は、後で sweep をアクティブ化するために使用する sweep_id を返します。

コマンドライン では、この関数は次のように置き換えられます

ターミナル で W&B Sweeps を作成する方法の詳細については、W&B Sweep チュートリアル を参照してください。

ステップ3:機械学習 コード を定義する

sweep を実行する前に、

試してみたい ハイパーパラメーター 値を使用するトレーニング プロシージャ を定義します。W&B Sweeps をトレーニング コード に統合するための鍵は、各トレーニング 実験 で、トレーニング ロジックが sweep 設定で定義した ハイパーパラメーター 値に アクセス できるようにすることです。

次の コード 例では、ヘルパー関数 build_dataset、build_network、build_optimizer、および train_epoch が sweep ハイパーパラメーター 設定 辞書 に アクセス します。

次の機械学習 トレーニング コード を ノートブック で実行します。これらの関数は、PyTorch で基本的な完全接続 ニューラルネットワーク を定義します。

import torch

import torch.optim as optim

import torch.nn.functional as F

import torch.nn as nn

from torchvision import datasets, transforms

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

def train(config=None):

# Initialize a new wandb run

with wandb.init(config=config):

# If called by wandb.agent, as below,

# this config will be set by Sweep Controller

config = wandb.config

loader = build_dataset(config.batch_size)

network = build_network(config.fc_layer_size, config.dropout)

optimizer = build_optimizer(network, config.optimizer, config.learning_rate)

for epoch in range(config.epochs):

avg_loss = train_epoch(network, loader, optimizer)

wandb.log({"loss": avg_loss, "epoch": epoch})

train 関数内では、次の W&B Python SDK メソッドに注意してください。

次のセルは、4つの関数(build_dataset、build_network、build_optimizer、および train_epoch)を定義します。

これらの関数は、基本的な PyTorch パイプライン の標準的な部分であり、

その実装は W&B の使用による影響を受けません。

def build_dataset(batch_size):

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))])

# download MNIST training dataset

dataset = datasets.MNIST(".", train=True, download=True,

transform=transform)

sub_dataset = torch.utils.data.Subset(

dataset, indices=range(0, len(dataset), 5))

loader = torch.utils.data.DataLoader(sub_dataset, batch_size=batch_size)

return loader

def build_network(fc_layer_size, dropout):

network = nn.Sequential( # fully connected, single hidden layer

nn.Flatten(),

nn.Linear(784, fc_layer_size), nn.ReLU(),

nn.Dropout(dropout),

nn.Linear(fc_layer_size, 10),

nn.LogSoftmax(dim=1))

return network.to(device)

def build_optimizer(network, optimizer, learning_rate):

if optimizer == "sgd":

optimizer = optim.SGD(network.parameters(),

lr=learning_rate, momentum=0.9)

elif optimizer == "adam":

optimizer = optim.Adam(network.parameters(),

lr=learning_rate)

return optimizer

def train_epoch(network, loader, optimizer):

cumu_loss = 0

for _, (data, target) in enumerate(loader):

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

# ➡ Forward pass

loss = F.nll_loss(network(data), target)

cumu_loss += loss.item()

# ⬅ Backward pass + weight update

loss.backward()

optimizer.step()

wandb.log({"batch loss": loss.item()})

return cumu_loss / len(loader)

PyTorch で W&B を使用した計測の詳細については、この Colab を参照してください。

ステップ4: sweep agent をアクティブ化する

sweep 設定を定義し、インタラクティブな方法でこれらの ハイパーパラメーター を利用できるトレーニング スクリプト を作成したので、 sweep agent をアクティブ化する準備ができました。 Sweep agent は、 sweep 設定で定義した ハイパーパラメーター 値のセットを使用して 実験 を実行する役割を担います。

wandb.agent メソッドを使用して sweep agent を作成します。以下を指定してください。

- agent が属する sweep (

sweep_id)

- sweep が実行することになっている関数。この例では、 sweep は

train 関数を使用します。

- (オプション) sweep コントローラ に要求する設定の数 (

count)

異なるコンピューティング リソース 上で、同じ sweep_id を持つ複数の sweep agent を開始できます。 sweep コントローラ は、定義した sweep 設定に従って連携するようにします。

次のセルは、トレーニング 関数 (train) を5回実行する sweep agent をアクティブ化します。

wandb.agent(sweep_id, train, count=5)

random 検索方法が sweep 設定で指定されているため、 sweep コントローラ は ランダム に生成された ハイパーパラメーター 値を提供します。

ターミナル で W&B Sweeps を作成する方法の詳細については、W&B Sweep チュートリアル を参照してください。

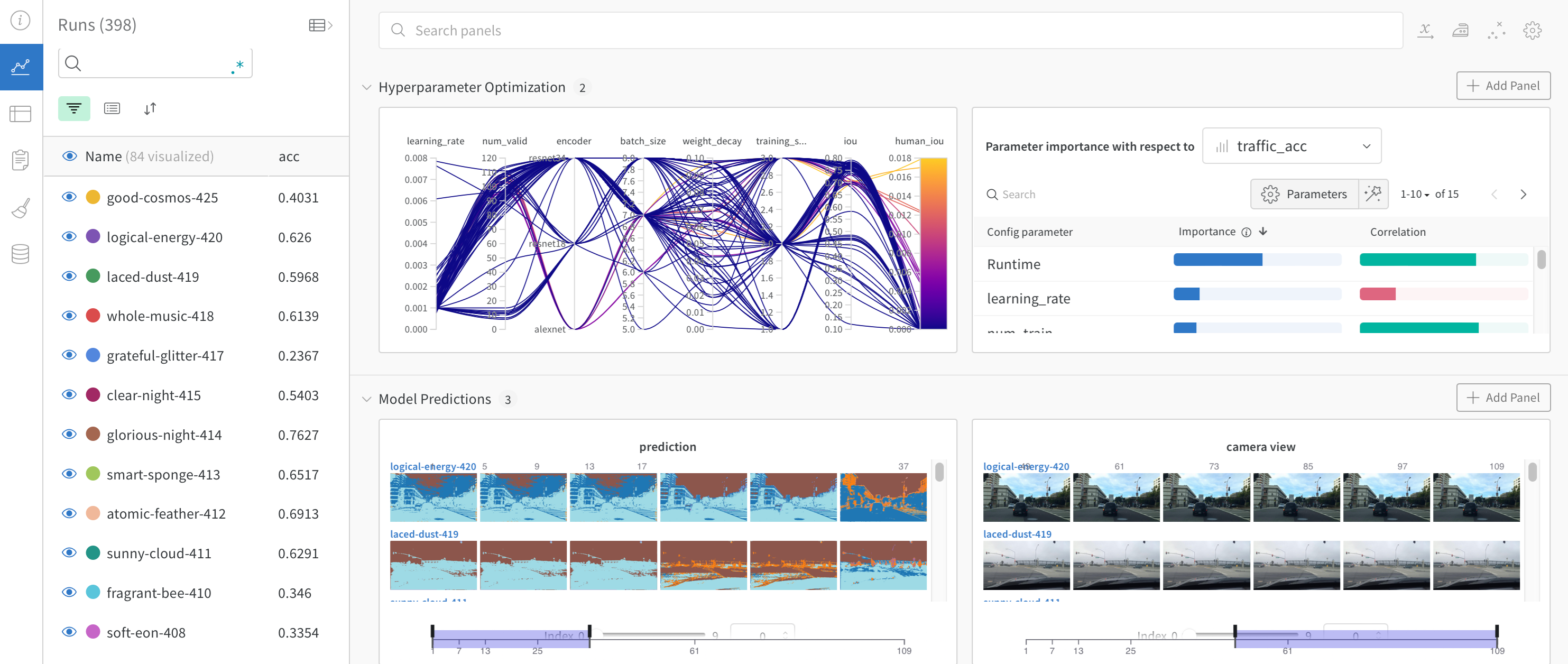

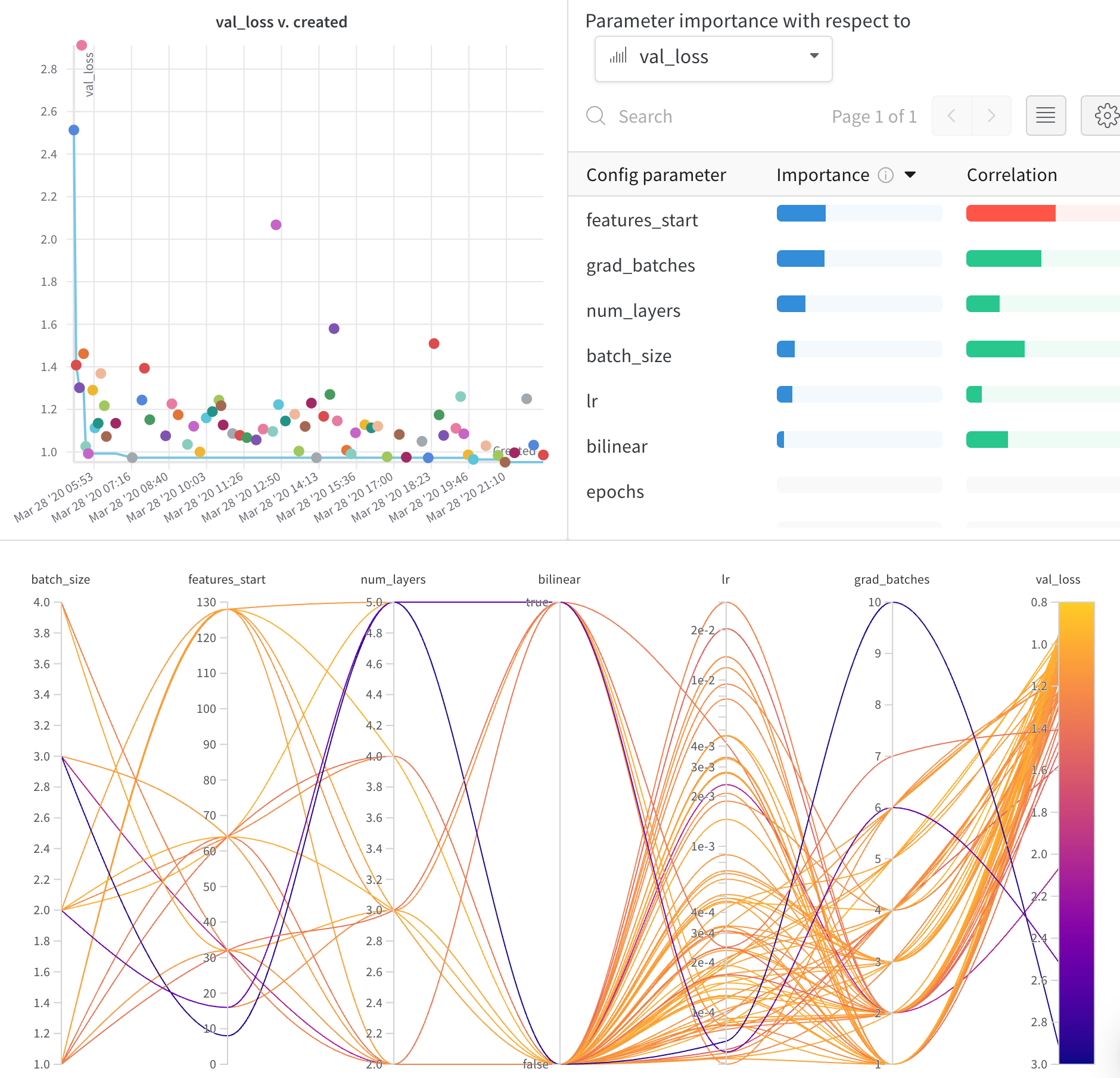

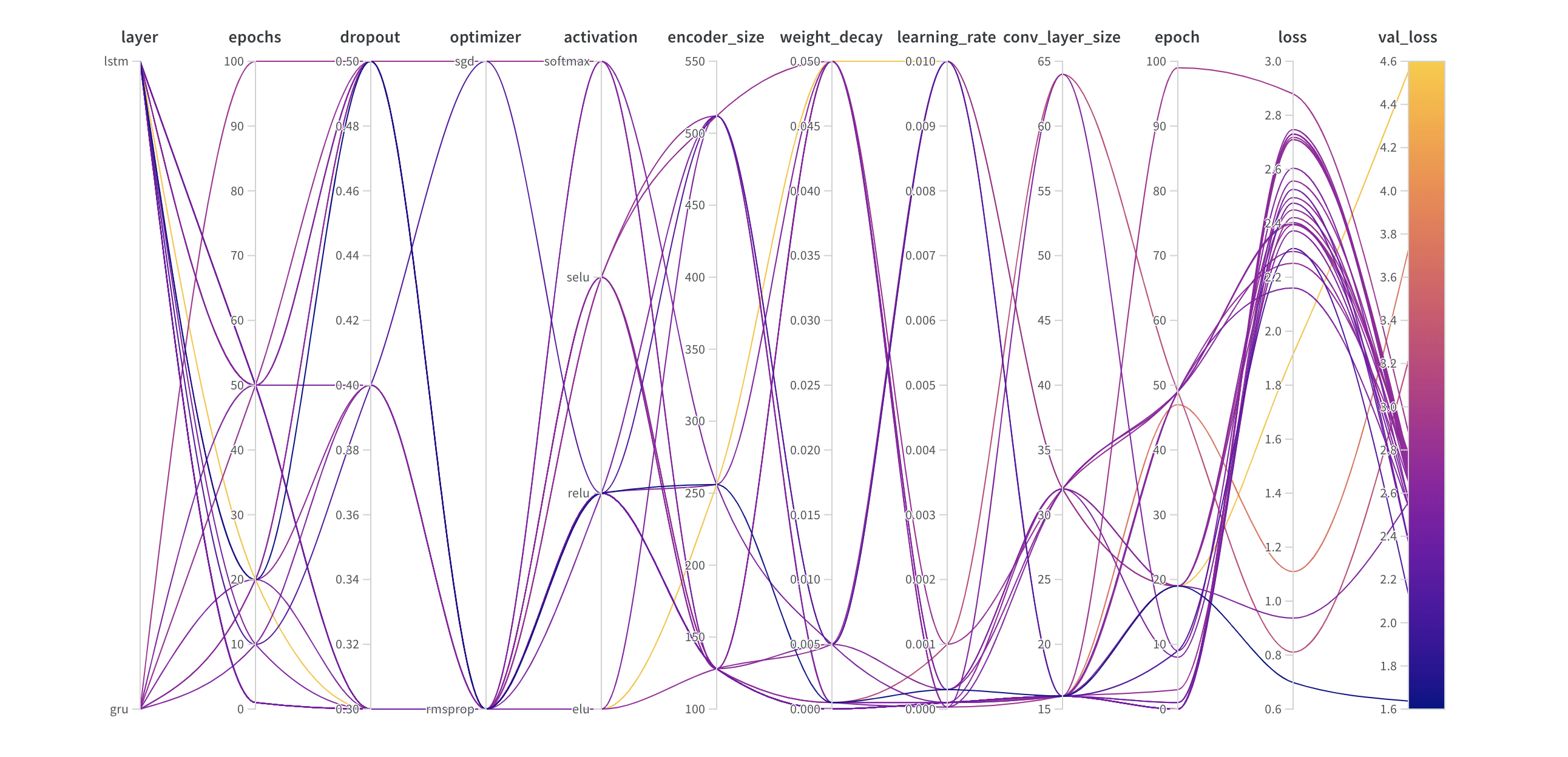

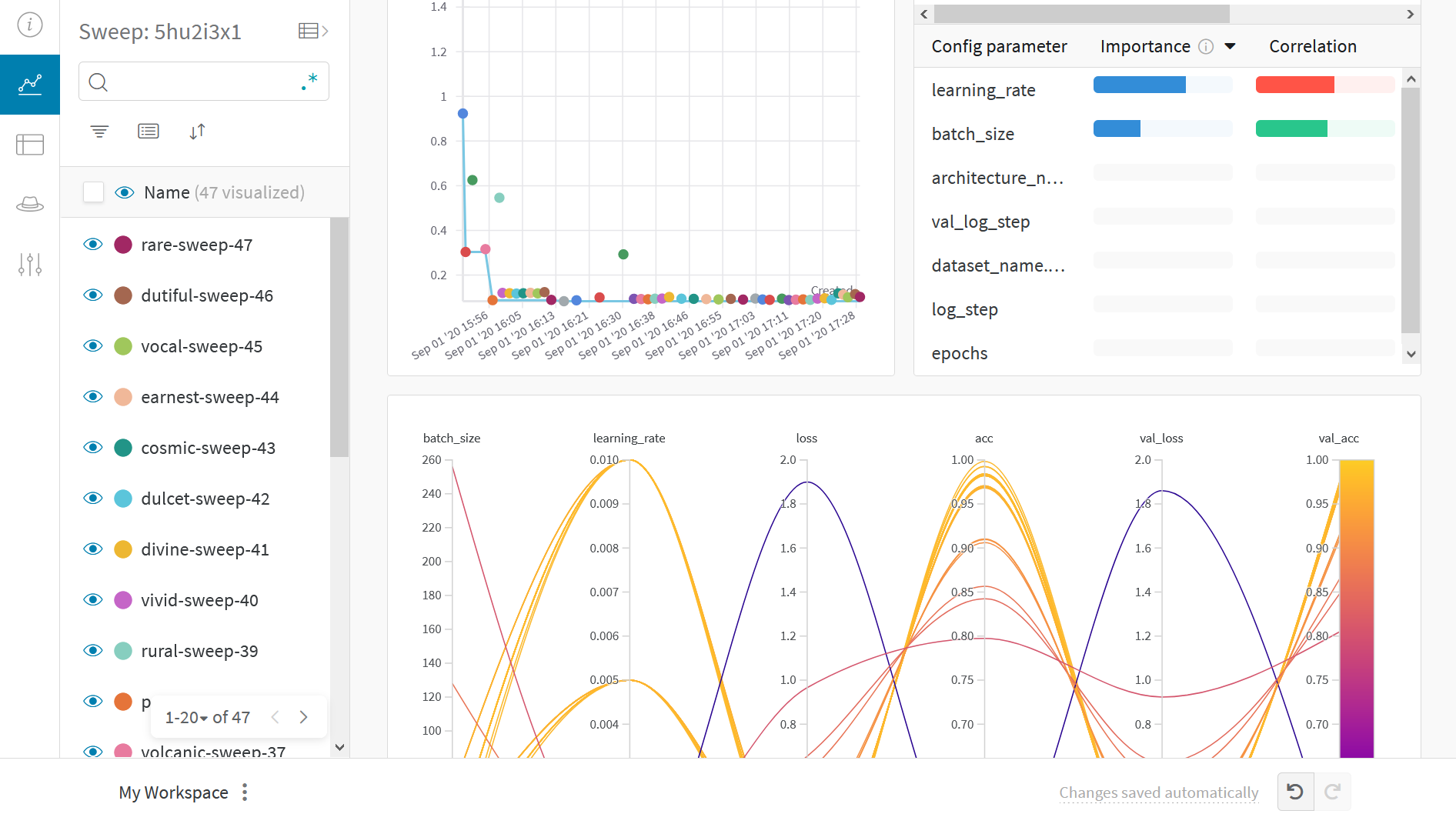

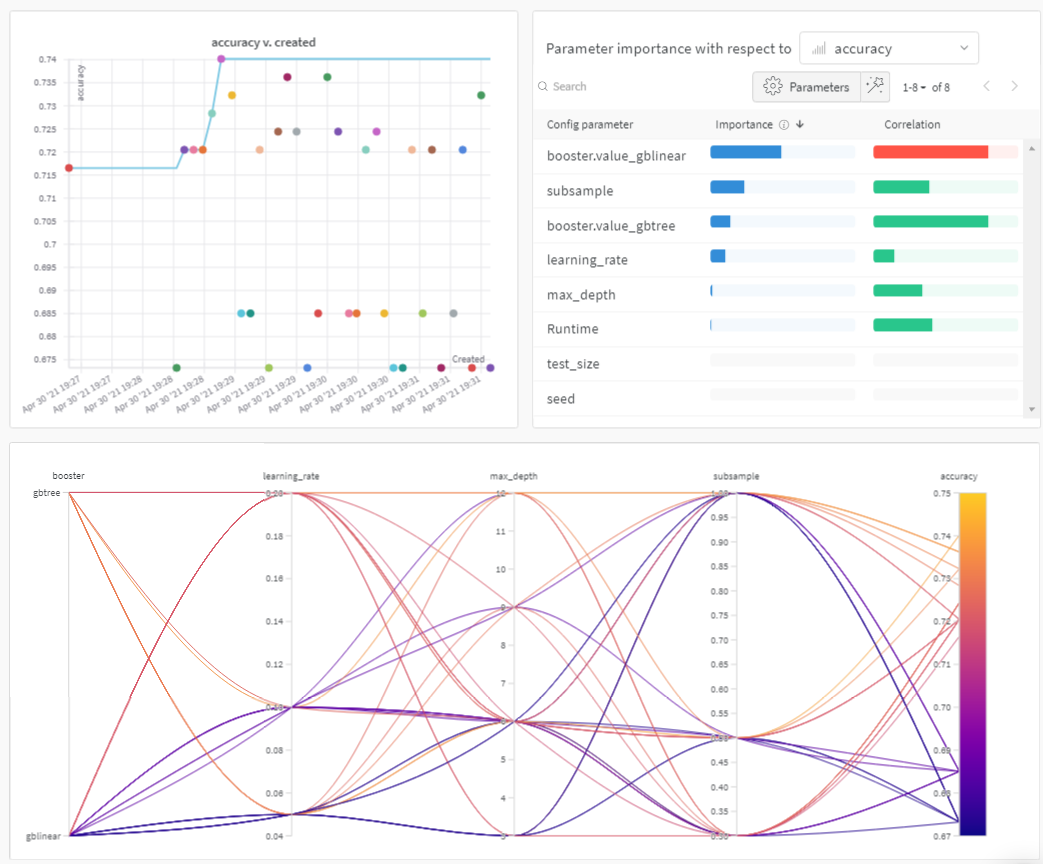

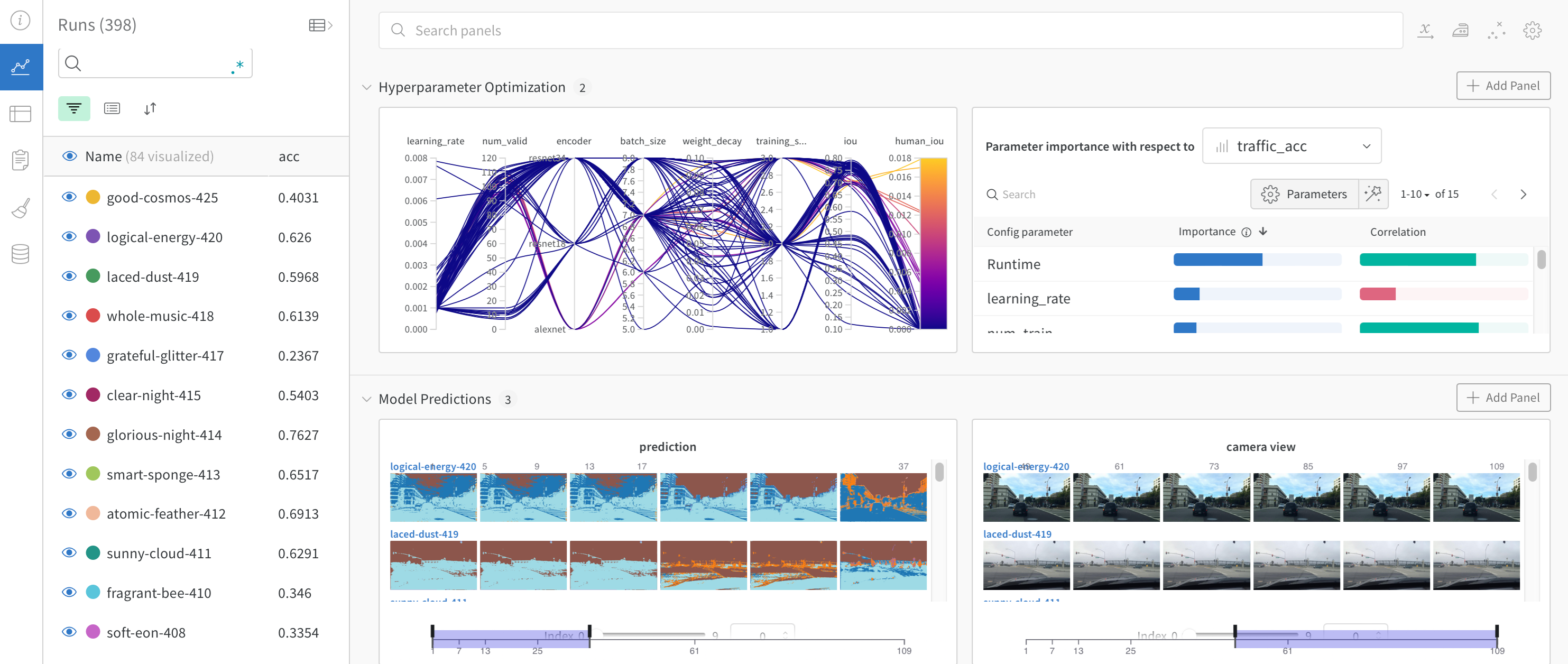

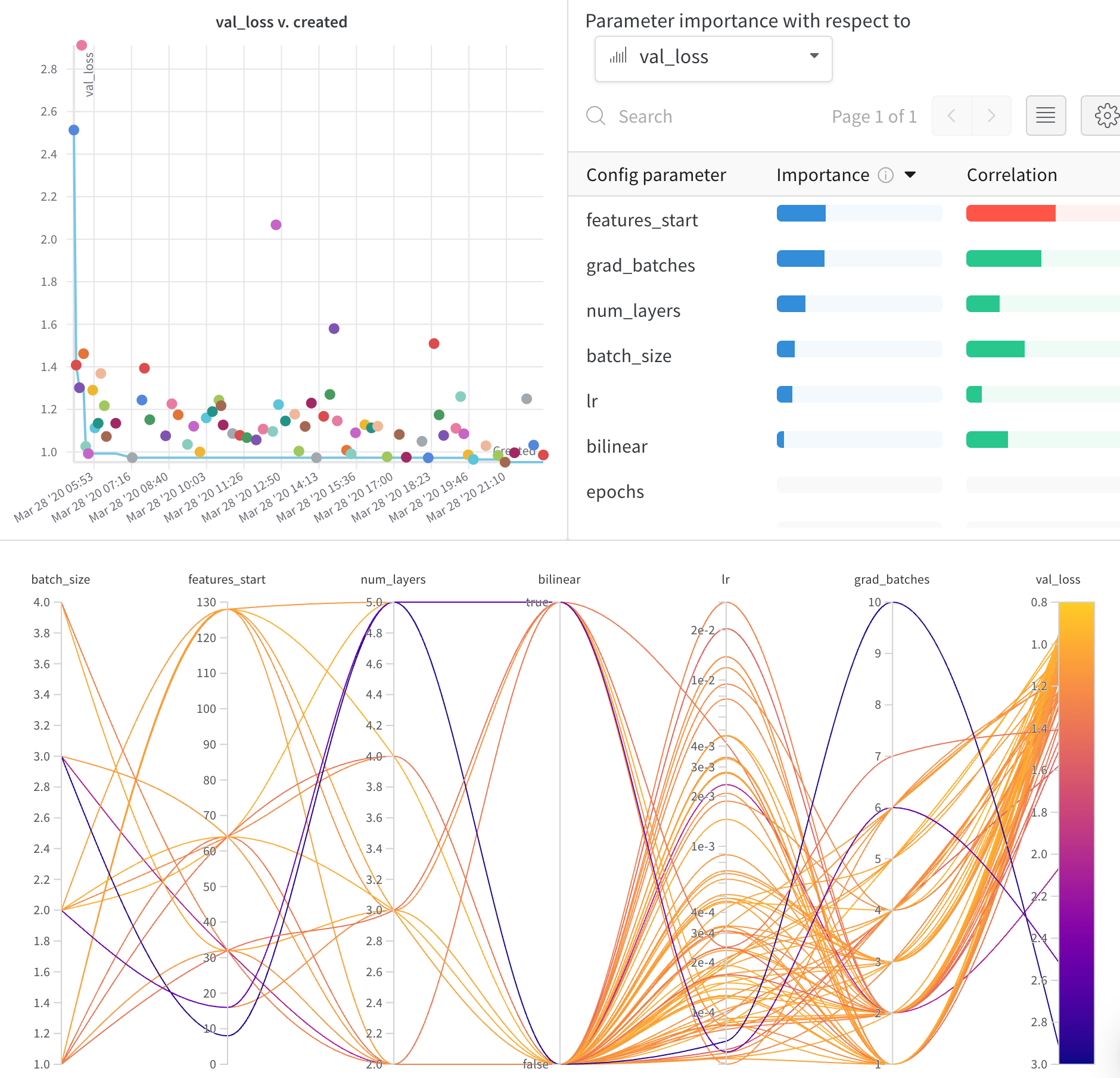

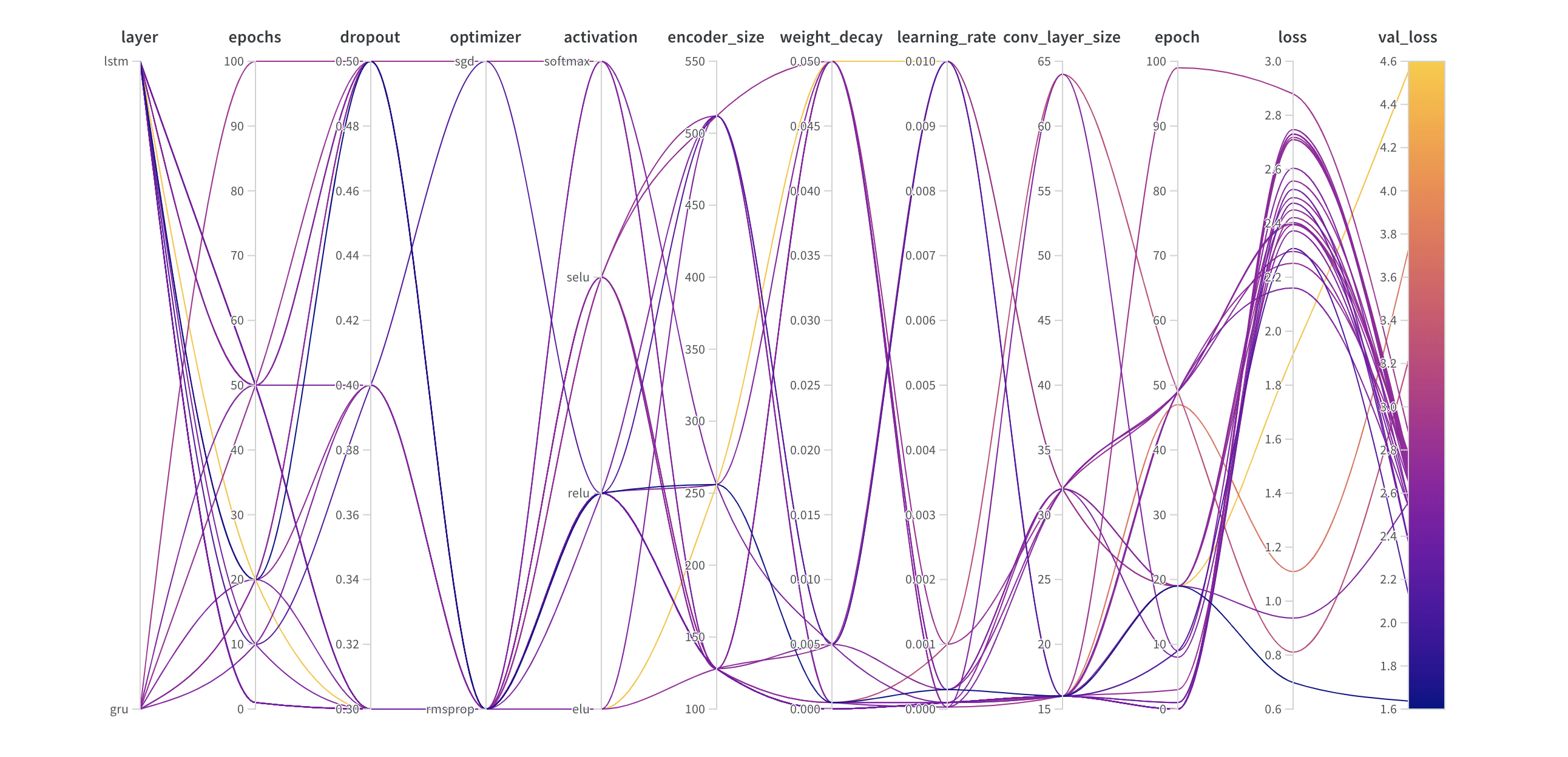

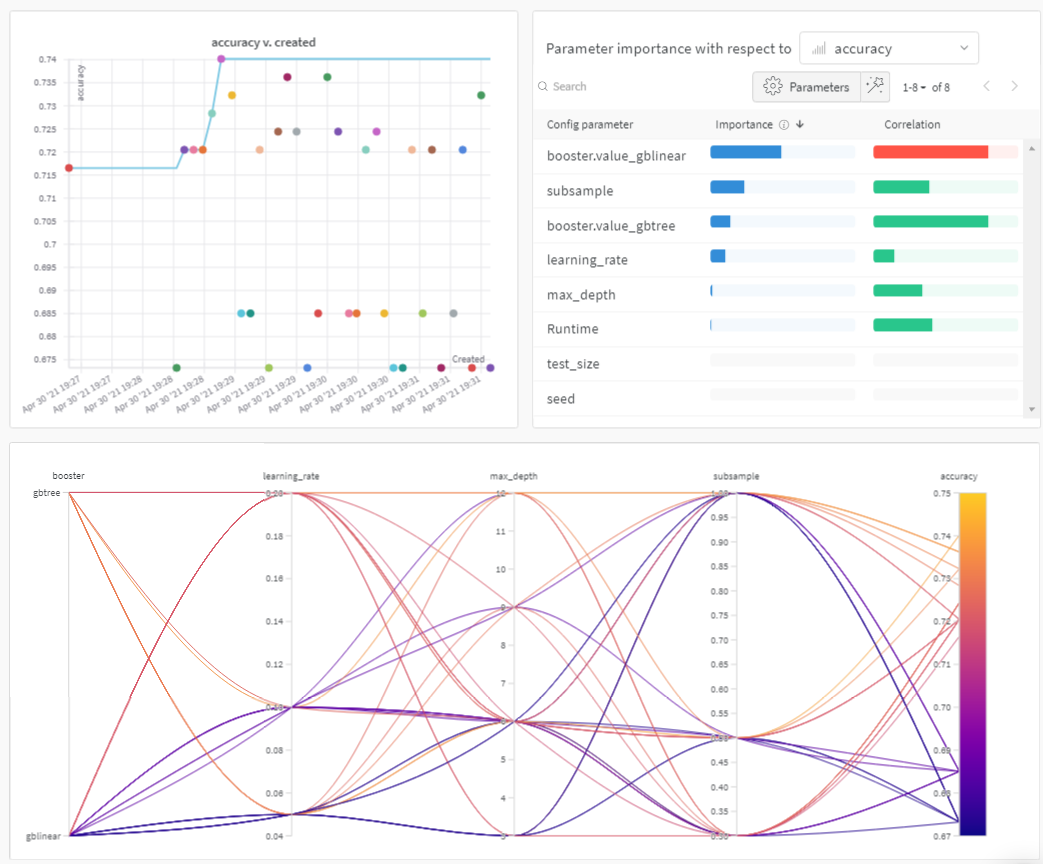

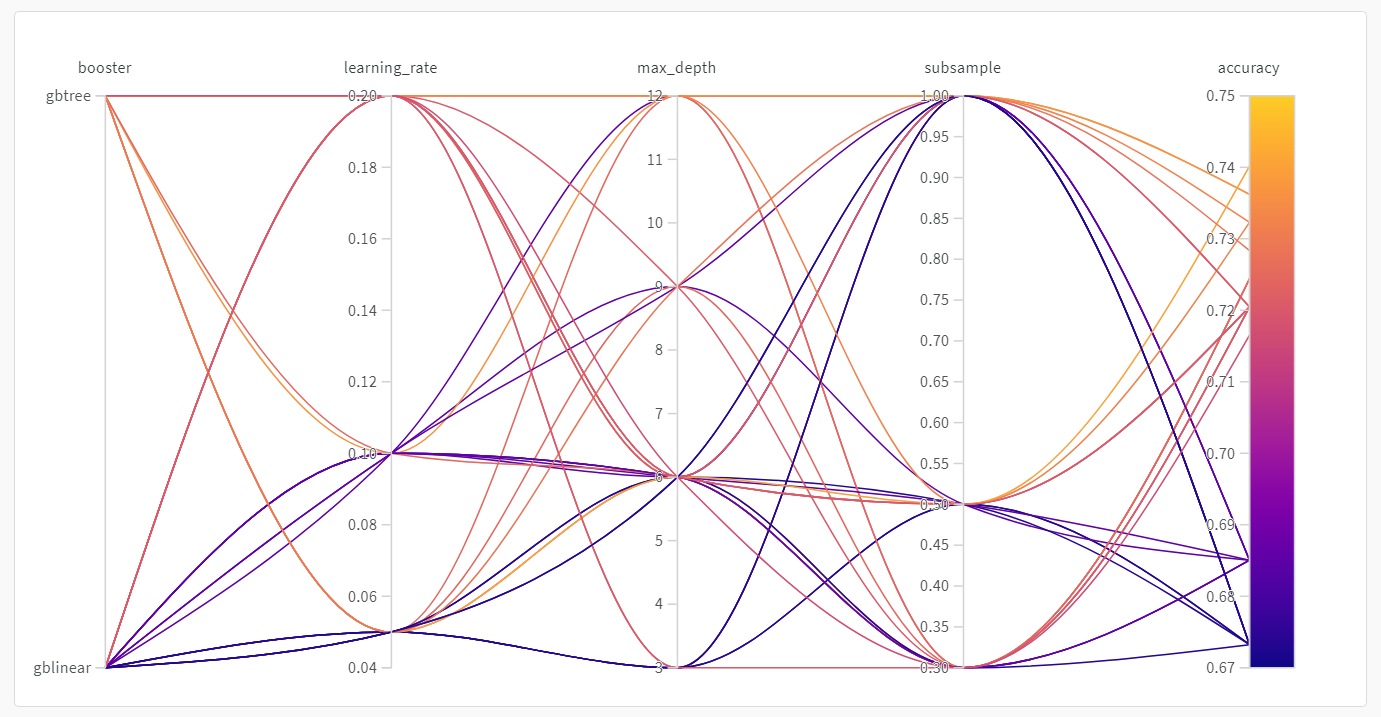

Sweep の結果を 可視化 する

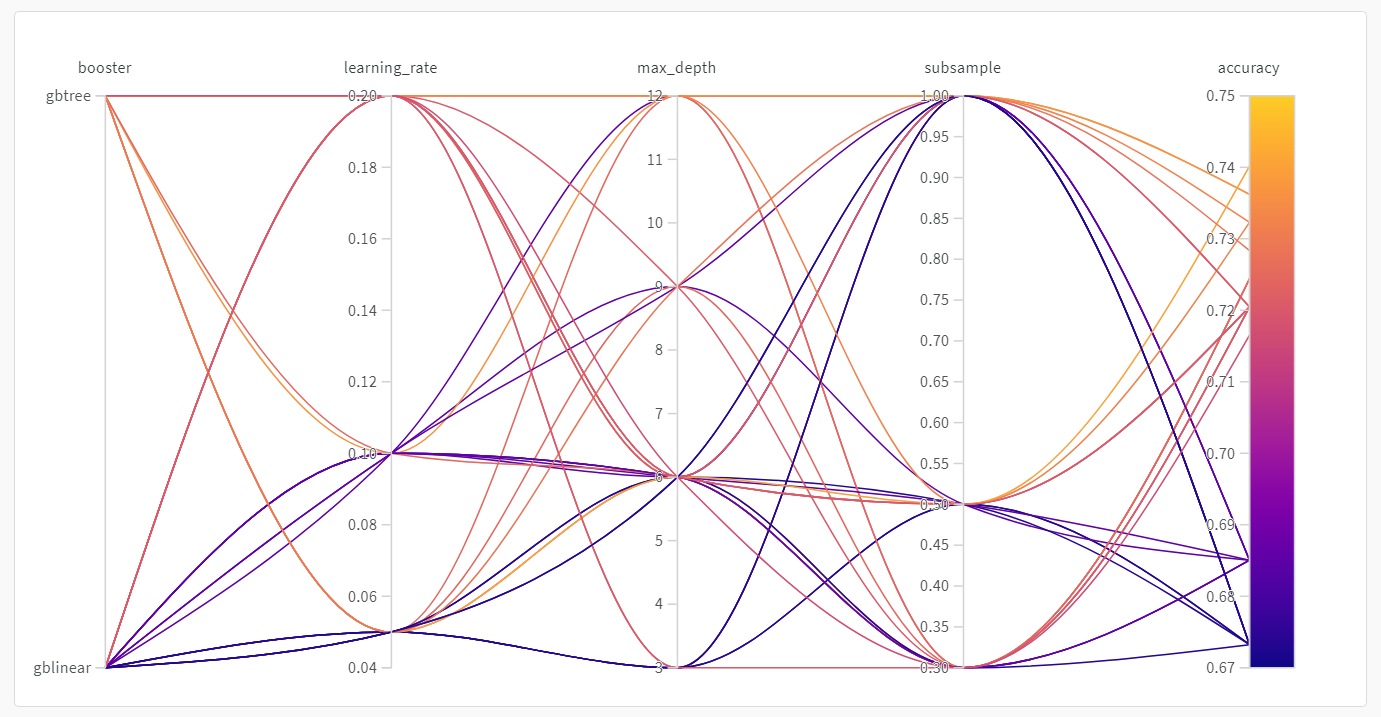

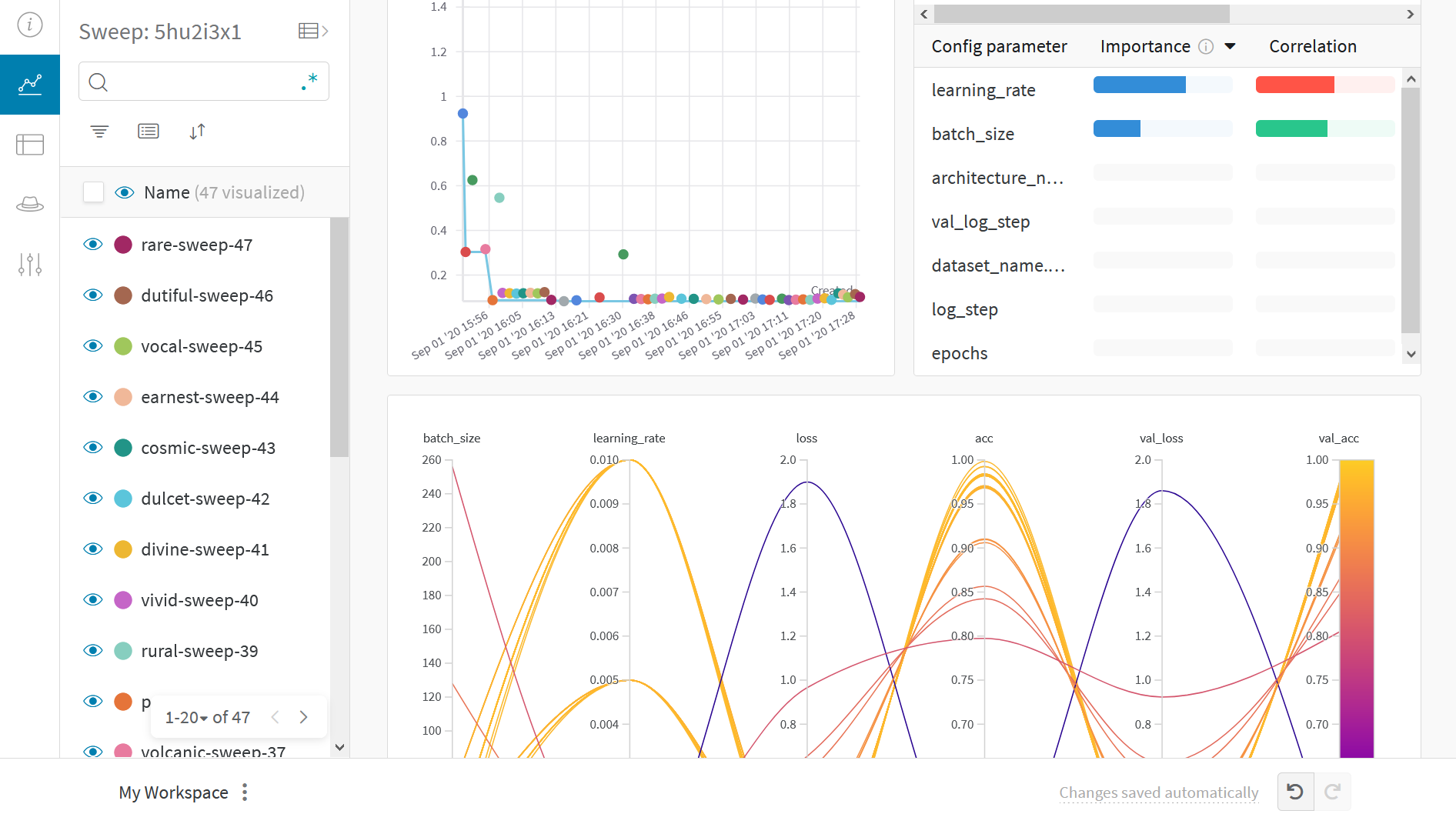

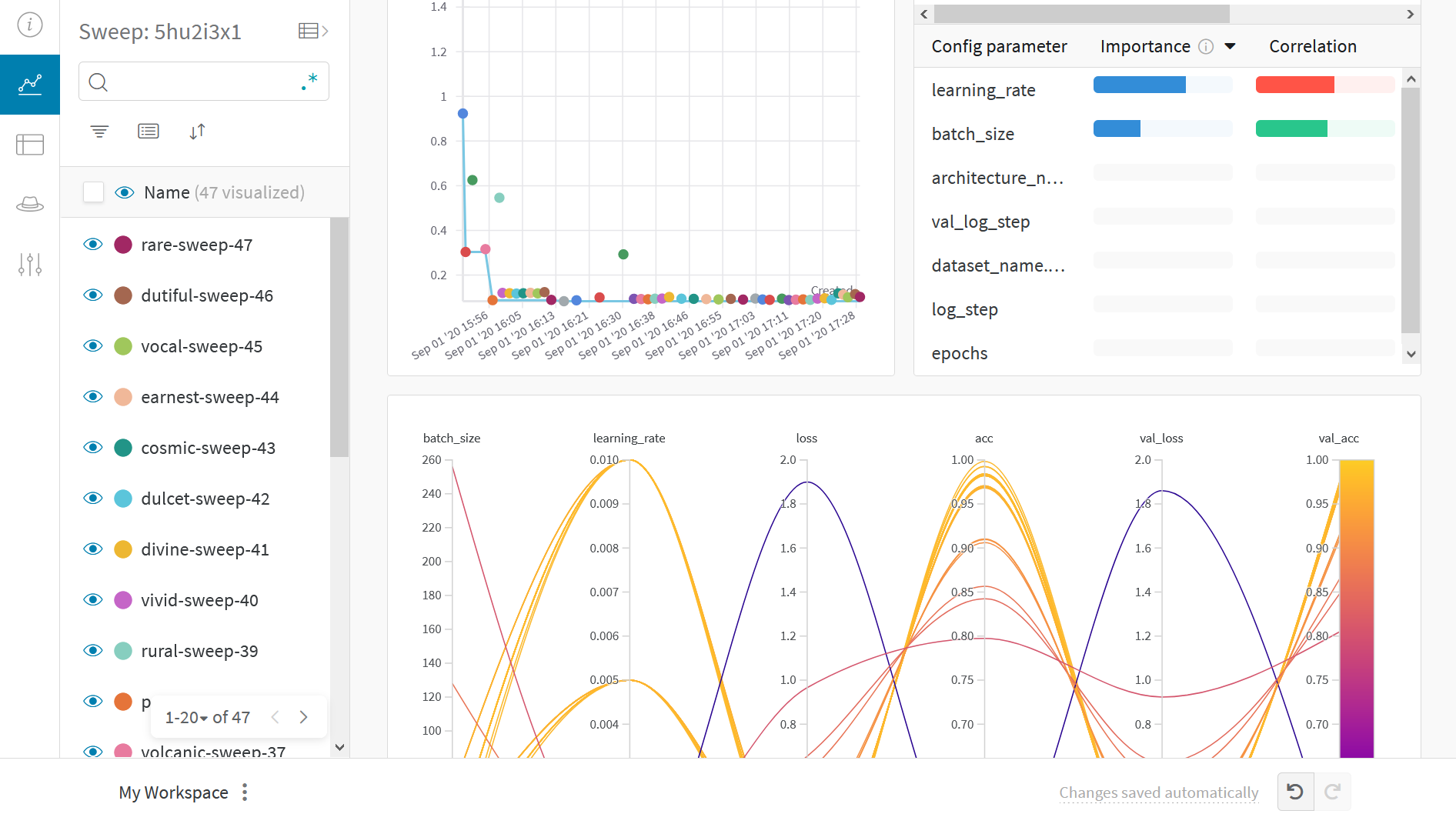

並列座標プロット

このプロットは、 ハイパーパラメーター 値をモデル メトリクス にマッピングします。これは、最高のモデル パフォーマンス につながった ハイパーパラメーター の組み合わせを調整するのに役立ちます。

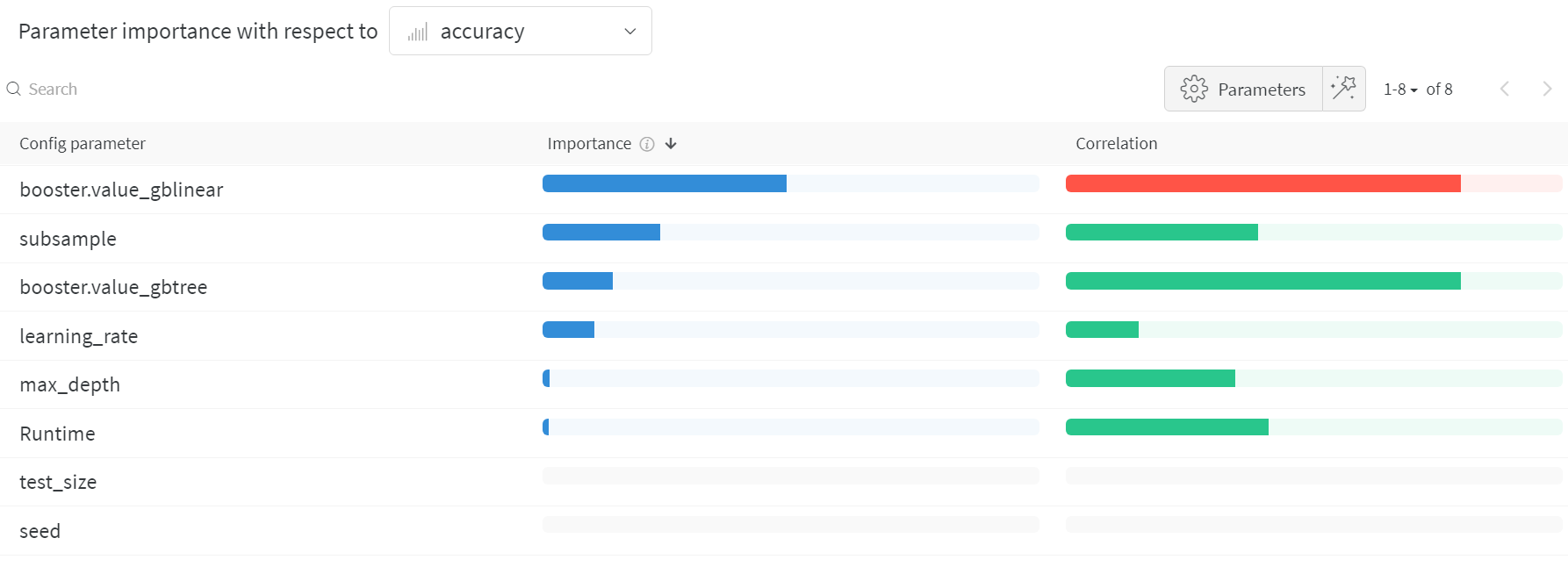

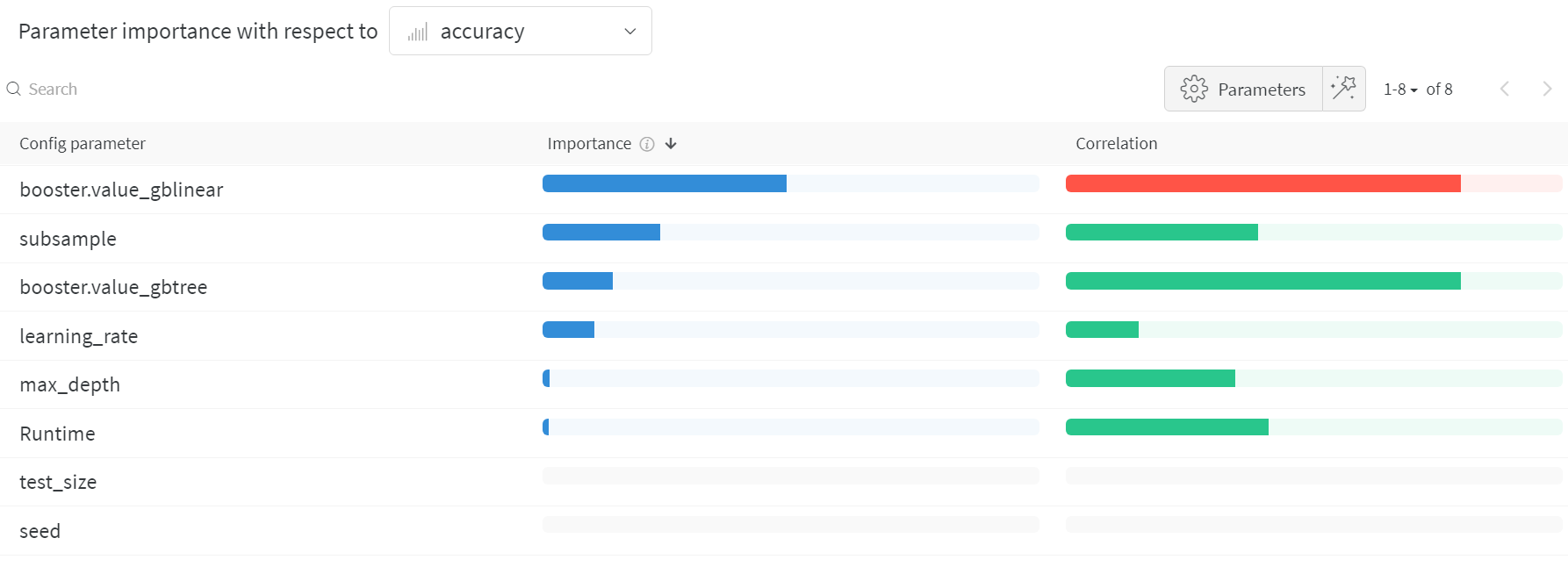

ハイパーパラメーター インポータンスプロット

ハイパーパラメーター インポータンスプロット は、どの ハイパーパラメーター が メトリクス の最良の予測因子であるかを表面化します。

特徴量の重要度( ランダム フォレスト モデル から)と相関関係(暗黙的に線形モデル)を報告します。

これらの 可視化 は、最も重要な パラメータ (および値の範囲)を絞り込むことで、高価な ハイパーパラメーター 最適化を実行する時間とリソースを節約するのに役立ち、それによってさらに調査する価値があります。

W&B Sweeps の詳細

単純なトレーニング スクリプト と、試せる いくつかの種類の sweep 設定 を作成しました。これらを試してみることを強くお勧めします。

その リポジトリ には、ベイズ Hyperband や Hyperopt などの、より高度な sweep 機能を試すのに役立つ例もあります。

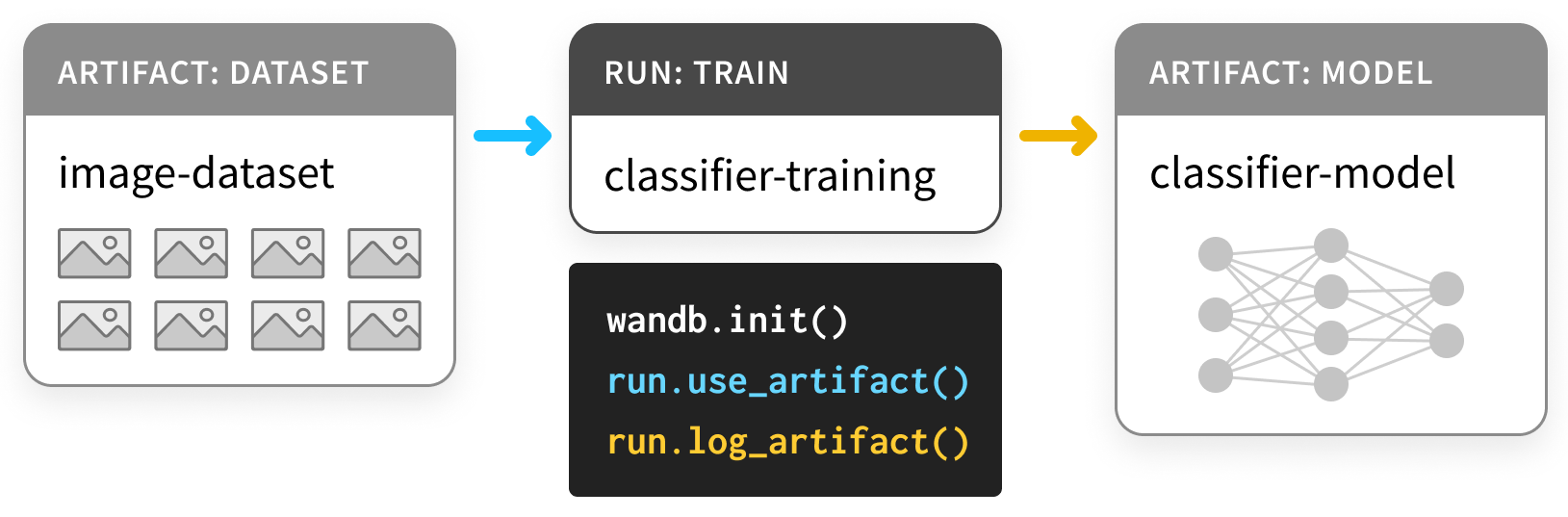

4 - Track models and datasets

このノートブックでは、W&B Artifacts を使用して ML 実験パイプラインを追跡する方法を紹介します。

ビデオチュートリアルをご覧ください。

Artifacts について

Artifact は、ギリシャのアンフォラのように、

生成されたオブジェクト、つまりプロセスの出力です。

ML で最も重要な Artifact は、 データセット と モデル です。

そして、コロナドの十字架のように、これらの重要な Artifact は博物館に属します。

つまり、あなた、あなたの Team、そして ML コミュニティ全体がそれらから学ぶことができるように、カタログ化され、整理されるべきです。

結局のところ、トレーニングを追跡しない人は、それを繰り返す運命にあります。

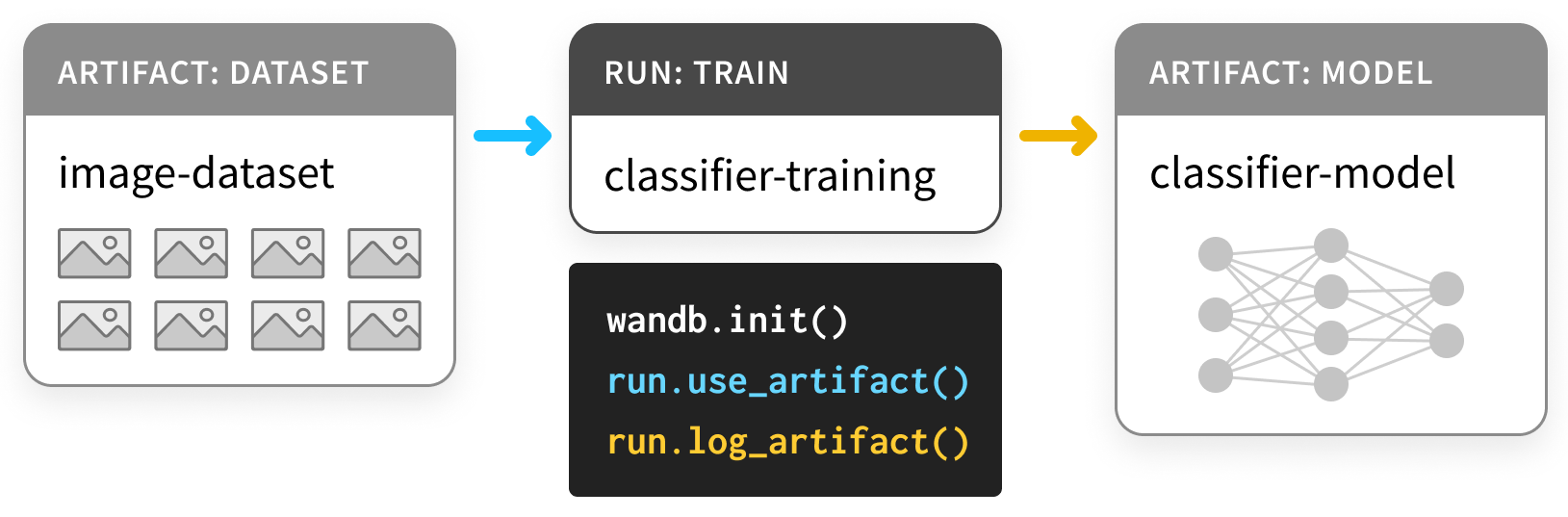

Artifacts API を使用すると、次の図のように、W&B Run の出力として Artifact をログに記録したり、Artifact を Run への入力として使用したりできます。

ここでは、トレーニング run がデータセットを取り込み、モデルを生成します。

1 つの run が別の run の出力を入力として使用できるため、Artifact と Run はまとめて有向グラフ (2 部 DAG) を形成します。Artifact と Run のノードと、Run を消費または生成する Artifact に接続する矢印があります。

Artifacts を使用してモデルとデータセットを追跡する

インストールとインポート

Artifacts は、バージョン 0.9.2 以降の Python ライブラリの一部です。

ML Python スタックのほとんどの部分と同様に、pip 経由で利用できます。

# Compatible with wandb version 0.9.2+

!pip install wandb -qqq

!apt install tree

データセットのログ

まず、いくつかの Artifacts を定義しましょう。

この例は、この PyTorch

“基本的な MNIST の例”

に基づいています。

TensorFlowや他の framework、

または純粋な Python でも簡単に実行できます。

Dataset から始めましょう。

- パラメータを選択するための

train ニング セット

- ハイパーパラメータを選択するための

validation セット

- 最終モデルを評価するための

test ニング セット

以下の最初のセルは、これら 3 つのデータセットを定義します。

import random

import torch

import torchvision

from torch.utils.data import TensorDataset

from tqdm.auto import tqdm

# Ensure deterministic behavior

torch.backends.cudnn.deterministic = True

random.seed(0)

torch.manual_seed(0)

torch.cuda.manual_seed_all(0)

# Device configuration

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

# Data parameters

num_classes = 10

input_shape = (1, 28, 28)

# drop slow mirror from list of MNIST mirrors

torchvision.datasets.MNIST.mirrors = [mirror for mirror in torchvision.datasets.MNIST.mirrors

if not mirror.startswith("http://yann.lecun.com")]

def load(train_size=50_000):

"""

# データのロード

"""

# the data, split between train and test sets

train = torchvision.datasets.MNIST("./", train=True, download=True)

test = torchvision.datasets.MNIST("./", train=False, download=True)

(x_train, y_train), (x_test, y_test) = (train.data, train.targets), (test.data, test.targets)

# split off a validation set for hyperparameter tuning

x_train, x_val = x_train[:train_size], x_train[train_size:]

y_train, y_val = y_train[:train_size], y_train[train_size:]

training_set = TensorDataset(x_train, y_train)

validation_set = TensorDataset(x_val, y_val)

test_set = TensorDataset(x_test, y_test)

datasets = [training_set, validation_set, test_set]

return datasets

これは、この例で繰り返されるパターンを設定します。

Artifact としてデータをログに記録するコードは、データの

生成コードの周りにラップされます。

この場合、データを load するコードは、

データを load_and_log するコードから分離されています。

これは良い習慣です。

これらのデータセットを Artifacts としてログに記録するには、

次の手順が必要です。

wandb.init で Run を作成し (L4)、- データセットの

Artifact を作成し (L10)、

- 関連する

file を保存してログに記録します (L20、L23)。

以下のコードセルの例を確認し、後でセクションを展開して詳細を確認してください。

def load_and_log():

# 🚀 run を開始し、それにラベルを付ける type と、ホームと呼ぶことができる project を指定します

with wandb.init(project="artifacts-example", job_type="load-data") as run:

datasets = load() # データセットをロードするための個別のコード

names = ["training", "validation", "test"]

# 🏺 Artifact を作成

raw_data = wandb.Artifact(

"mnist-raw", type="dataset",

description="Raw MNIST dataset, split into train/val/test",

metadata={"source": "torchvision.datasets.MNIST",

"sizes": [len(dataset) for dataset in datasets]})

for name, data in zip(names, datasets):

# 🐣 Artifact に新しいファイルを保存し、そのコンテンツに何かを書き込みます。

with raw_data.new_file(name + ".pt", mode="wb") as file:

x, y = data.tensors

torch.save((x, y), file)

# ✍️ Artifact を W&B に保存します。

run.log_artifact(raw_data)

load_and_log()

wandb.init

Artifact を生成する Run を作成するときは、

どの project に属するかを明記する必要があります。

workflow によっては、

project は car-that-drives-itself ほど大きくても、

iterative-architecture-experiment-117 ほど小さくてもかまいません。

経験則: 可能であれば、Artifact を共有するすべての Run を

1 つの project 内に保持します。これにより、物事がシンプルになりますが、心配しないでください。Artifact は project 間で移植可能です。

実行する可能性のあるさまざまな種類のジョブをすべて追跡するために、

Run を作成するときに job_type を指定すると便利です。

これにより、Artifact のグラフがすっきりと整理されます。

経験則: job_type は記述的であり、パイプラインの 1 つのステップに対応する必要があります。ここでは、データの load とデータの preprocess を分離しています。

wandb.Artifact

何かを Artifact としてログに記録するには、最初に Artifact オブジェクトを作成する必要があります。

すべての Artifact には name があります。これは、最初の引数で設定されます。

経験則: name は記述的である必要がありますが、覚えやすく、入力しやすい必要があります。

ハイフンで区切られ、コード内の変数名に対応する名前を使用することをお勧めします。

また、type もあります。Run の job_type と同様に、

これは Run と Artifact のグラフを整理するために使用されます。

経験則: type はシンプルにする必要があります。

mnist-data-YYYYMMDD よりも dataset や model に近いものにします。

また、description といくつかの metadata を辞書として添付することもできます。

metadata は、JSON にシリアル化できる必要があります。

経験則: metadata は可能な限り記述的にする必要があります。

artifact.new_file と run.log_artifact

Artifact オブジェクトを作成したら、それにファイルを追加する必要があります。

そのとおりです。ファイル です。

Artifact はディレクトリーのように構造化されており、

ファイルとサブディレクトリーがあります。

経験則: 可能な場合は常に、

Artifact の内容を複数のファイルに分割します。これは、スケーリングするときに役立ちます。

new_file メソッドを使用して、

ファイルを同時に書き込み、Artifact に添付します。

以下では、add_file メソッドを使用します。

これにより、これら 2 つのステップが分離されます。

すべてのファイルを追加したら、wandb.ai に log_artifact する必要があります。

出力に URL がいくつか表示されます。

Run ページの URL も含まれています。

これは、ログに記録された Artifact を含む、Run の結果を表示できる場所です。

以下では、Run ページの他のコンポーネントをより有効に活用する例をいくつか示します。

ログに記録されたデータセット Artifact の使用

博物館の Artifact とは異なり、W&B の Artifact は、

保存されるだけでなく、使用 されるように設計されています。

それがどのようなものかを見てみましょう。

以下のセルは、生のデータセットを受け取るパイプライン ステップを定義します

。これを使用して、preprocess されたデータセットを生成します。

normalize され、正しく整形されています。

wandb とやり取りするコードから、コードの重要な部分である preprocess を分割していることに再び注意してください。

def preprocess(dataset, normalize=True, expand_dims=True):

"""

## データの準備

"""

x, y = dataset.tensors

if normalize:

# Scale images to the [0, 1] range

x = x.type(torch.float32) / 255

if expand_dims:

# Make sure images have shape (1, 28, 28)

x = torch.unsqueeze(x, 1)

return TensorDataset(x, y)

次に、wandb.Artifact ロギングでこの preprocess ステップをインストルメント化するコードを示します。

以下の例では、Artifact を use していること、

これは新しいこと、

そしてそれを log していること、

これは最後のステップと同じであることに注意してください。

Artifact は、Run の入力と出力の両方です。

新しい job_type である preprocess-data を使用して、

これが前のジョブとは異なる種類のジョブであることを明確にします。

def preprocess_and_log(steps):

with wandb.init(project="artifacts-example", job_type="preprocess-data") as run:

processed_data = wandb.Artifact(

"mnist-preprocess", type="dataset",

description="Preprocessed MNIST dataset",

metadata=steps)

# ✔️ 使用する Artifact を宣言します

raw_data_artifact = run.use_artifact('mnist-raw:latest')

# 📥 必要に応じて、Artifact をダウンロードします

raw_dataset = raw_data_artifact.download()

for split in ["training", "validation", "test"]:

raw_split = read(raw_dataset, split)

processed_dataset = preprocess(raw_split, **steps)

with processed_data.new_file(split + ".pt", mode="wb") as file:

x, y = processed_dataset.tensors

torch.save((x, y), file)

run.log_artifact(processed_data)

def read(data_dir, split):

filename = split + ".pt"

x, y = torch.load(os.path.join(data_dir, filename))

return TensorDataset(x, y)

ここで注意すべきことの 1 つは、preprocessing の steps

が preprocessed_data とともに metadata として保存されることです。

実験を再現可能にしようとしている場合は、

多くの metadata をキャプチャすることをお勧めします。

また、データセットが「large artifact」であっても、

download ステップは 1 秒もかからずに完了します。

詳細については、以下の markdown セルを展開してください。

steps = {"normalize": True,

"expand_dims": True}

preprocess_and_log(steps)

run.use_artifact

これらの手順はより簡単です。コンシューマーは、Artifact の name と、もう少しだけ知る必要があります。

その「もう少し」とは、必要な Artifact の特定のバージョンの alias です。

デフォルトでは、最後にアップロードされたバージョンには latest というタグが付けられます。

それ以外の場合は、v0/v1 などを使用して古いバージョンを選択するか、best や jit-script などの独自のエイリアスを指定できます。

Docker Hub タグと同様に、

エイリアスは名前と : で区切られているため、

必要な Artifact は mnist-raw:latest です。

経験則: エイリアスは短く簡潔に保ちます。

Artifact が何らかのプロパティを満たすようにする場合は、latest や best などのカスタム alias を使用します

artifact.download

ここで、download 呼び出しについて心配しているかもしれません。

別のコピーをダウンロードすると、メモリへの負担が 2 倍になるのではないでしょうか。

ご心配なく。実際に何かをダウンロードする前に、

適切なバージョンがローカルで利用可能かどうかを確認します。

これには、torrenting と git によるバージョン管理 の基盤となるのと同じテクノロジーであるハッシュが使用されます。

Artifact が作成されてログに記録されると、

作業ディレクトリー内の artifacts というフォルダー

がサブディレクトリーでいっぱいになり始めます。

これは、各 Artifact に 1 つずつです。

!tree artifacts でその内容を確認してください。

Artifacts ページ

Artifact をログに記録して使用したので、

Run ページの Artifacts タブを確認してみましょう。

wandb 出力の Run ページの URL に移動し、

左側のサイドバーから [Artifacts] タブを選択します

(これはデータベース アイコンが付いたもので、

3 つのホッケー パックが互いに積み重ねられているように見えます)。

[Input Artifacts] テーブルまたは

[Output Artifacts] テーブルのいずれかの行をクリックし、

次にタブ ([Overview]、[Metadata])

をチェックして、Artifact についてログに記録されたすべての内容を確認します。

特に [Graph View] が気に入っています。

デフォルトでは、Artifact の type

と Run の job_type

を 2 種類のノードとして持つグラフが表示され、

矢印は消費と生産を表します。

モデルのログ

これで、Artifact の API の仕組みを理解するのに十分ですが、

この例をパイプラインの最後まで見てみましょう

。Artifact が ML workflow をどのように改善できるかを確認できます。

この最初のセルは、PyTorch で DNN model を構築します。これは、非常に単純な ConvNet です。

最初に model を初期化するだけで、トレーニングは行いません。

そうすることで、他のすべてを一定に保ちながら、トレーニングを繰り返すことができます。

from math import floor

import torch.nn as nn

class ConvNet(nn.Module):

def __init__(self, hidden_layer_sizes=[32, 64],

kernel_sizes=[3],

activation="ReLU",

pool_sizes=[2],

dropout=0.5,

num_classes=num_classes,

input_shape=input_shape):

super(ConvNet, self).__init__()

self.layer1 = nn.Sequential(

nn.Conv2d(in_channels=input_shape[0], out_channels=hidden_layer_sizes[0], kernel_size=kernel_sizes[0]),

getattr(nn, activation)(),

nn.MaxPool2d(kernel_size=pool_sizes[0])

)

self.layer2 = nn.Sequential(

nn.Conv2d(in_channels=hidden_layer_sizes[0], out_channels=hidden_layer_sizes[-1], kernel_size=kernel_sizes[-1]),

getattr(nn, activation)(),

nn.MaxPool2d(kernel_size=pool_sizes[-1])

)

self.layer3 = nn.Sequential(

nn.Flatten(),

nn.Dropout(dropout)

)

fc_input_dims = floor((input_shape[1] - kernel_sizes[0] + 1) / pool_sizes[0]) # layer 1 output size

fc_input_dims = floor((fc_input_dims - kernel_sizes[-1] + 1) / pool_sizes[-1]) # layer 2 output size

fc_input_dims = fc_input_dims*fc_input_dims*hidden_layer_sizes[-1] # layer 3 output size

self.fc = nn.Linear(fc_input_dims, num_classes)

def forward(self, x):

x = self.layer1(x)

x = self.layer2(x)

x = self.layer3(x)

x = self.fc(x)

return x

ここでは、W&B を使用して run を追跡しているため、

wandb.config

オブジェクトを使用して、すべてのハイパーパラメータを格納します。

その config オブジェクトの dict ional バージョンは、非常に役立つ metadata であるため、必ず含めてください。

def build_model_and_log(config):

with wandb.init(project="artifacts-example", job_type="initialize", config=config) as run:

config = wandb.config

model = ConvNet(**config)

model_artifact = wandb.Artifact(

"convnet", type="model",

description="Simple AlexNet style CNN",

metadata=dict(config))

torch.save(model.state_dict(), "initialized_model.pth")

# ➕ Artifact にファイルを追加する別の方法

model_artifact.add_file("initialized_model.pth")

wandb.save("initialized_model.pth")

run.log_artifact(model_artifact)

model_config = {"hidden_layer_sizes": [32, 64],

"kernel_sizes": [3],

"activation": "ReLU",

"pool_sizes": [2],

"dropout": 0.5,

"num_classes": 10}

build_model_and_log(model_config)

artifact.add_file

データセットのログの例のように、

new_file を同時に書き込んで Artifact に追加する代わりに、

1 つのステップでファイルを作成することもできます

(ここでは、torch.save)

してから、別のステップで Artifact に add します。

経験則: 重複を防ぐために、可能な限り new_file を使用します。

ログに記録されたモデル Artifact の使用

dataset で use_artifact を呼び出すことができるのと同様に、

initialized_model で呼び出して、別の Run で使用することができます。

今回は、model を train してみましょう。

詳細については、次の Colab を参照してください。

W&B を PyTorch でインストルメント化する。

import torch.nn.functional as F

def train(model, train_loader, valid_loader, config):

optimizer = getattr(torch.optim, config.optimizer)(model.parameters())

model.train()

example_ct = 0

for epoch in range(config.epochs):

for batch_idx, (data, target) in enumerate(train_loader):

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

output = model(data)

loss = F.cross_entropy(output, target)

loss.backward()

optimizer.step()

example_ct += len(data)

if batch_idx % config.batch_log_interval == 0:

print('Train Epoch: {} [{}/{} ({:.0%})]\tLoss: {:.6f}'.format(

epoch, batch_idx * len(data), len(train_loader.dataset),

batch_idx / len(train_loader), loss.item()))

train_log(loss, example_ct, epoch)

# evaluate the model on the validation set at each epoch

loss, accuracy = test(model, valid_loader)

test_log(loss, accuracy, example_ct, epoch)

def test(model, test_loader):

model.eval()

test_loss = 0

correct = 0

with torch.no_grad():

for data, target in test_loader:

data, target = data.to(device), target.to(device)

output = model(data)

test_loss += F.cross_entropy(output, target, reduction='sum') # sum up batch loss

pred = output.argmax(dim=1, keepdim=True) # get the index of the max log-probability

correct += pred.eq(target.view_as(pred)).sum()

test_loss /= len(test_loader.dataset)

accuracy = 100. * correct / len(test_loader.dataset)

return test_loss, accuracy

def train_log(loss, example_ct, epoch):

loss = float(loss)

# where the magic happens

wandb.log({"epoch": epoch, "train/loss": loss}, step=example_ct)

print(f"Loss after " + str(example_ct).zfill(5) + f" examples: {loss:.3f}")

def test_log(loss, accuracy, example_ct, epoch):

loss = float(loss)

accuracy = float(accuracy)

# where the magic happens

wandb.log({"epoch": epoch, "validation/loss": loss, "validation/accuracy": accuracy}, step=example_ct)

print(f"Loss/accuracy after " + str(example_ct).zfill(5) + f" examples: {loss:.3f}/{accuracy:.3f}")

今回は、2 つの別々の Artifact を生成する Run を実行します。

最初の model の train ニングが終了すると、

second は trained-model Artifact

を消費して、test_dataset でそのパフォーマンスを evaluate します。

また、ネットワークが最も混乱する 32 個の例も取り出します。

これは、categorical_crossentropy が最も高い例です。

これは、データセットとモデルの問題を診断するのに適した方法です。

def evaluate(model, test_loader):

"""

## トレーニング済みのモデルの評価

"""

loss, accuracy = test(model, test_loader)

highest_losses, hardest_examples, true_labels, predictions = get_hardest_k_examples(model, test_loader.dataset)

return loss, accuracy, highest_losses, hardest_examples, true_labels, predictions

def get_hardest_k_examples(model, testing_set, k=32):

model.eval()

loader = DataLoader(testing_set, 1, shuffle=False)

# get the losses and predictions for each item in the dataset

losses = None

predictions = None

with torch.no_grad():

for data, target in loader:

data, target = data.to(device), target.to(device)

output = model(data)

loss = F.cross_entropy(output, target)

pred = output.argmax(dim=1, keepdim=True)

if losses is None:

losses = loss.view((1, 1))

predictions = pred

else:

losses = torch.cat((losses, loss.view((1, 1))), 0)

predictions = torch.cat((predictions, pred), 0)

argsort_loss = torch.argsort(losses, dim=0)

highest_k_losses = losses[argsort_loss[-k:]]

hardest_k_examples = testing_set[argsort_loss[-k:]][0]

true_labels = testing_set[argsort_loss[-k:]][1]

predicted_labels = predictions[argsort_loss[-k:]]

return highest_k_losses, hardest_k_examples, true_labels, predicted_labels

これらのロギング関数は新しい Artifact 機能を追加しないため、

コメントは付けません。

Artifact を use、download、

および log しているだけです。

from torch.utils.data import DataLoader

def train_and_log(config):

with wandb.init(project="artifacts-example", job_type="train", config=config) as run:

config = wandb.config

data = run.use_artifact('mnist-preprocess:latest')

data_dir = data.download()

training_dataset = read(data_dir, "training")

validation_dataset = read(data_dir, "validation")

train_loader = DataLoader(training_dataset, batch_size=config.batch_size)

validation_loader = DataLoader(validation_dataset, batch_size=config.batch_size)

model_artifact = run.use_artifact("convnet:latest")

model_dir = model_artifact.download()

model_path = os.path.join(model_dir, "initialized_model.pth")

model_config = model_artifact.metadata

config.update(model_config)

model = ConvNet(**model_config)

model.load_state_dict(torch.load(model_path))

model = model.to(device)

train(model, train_loader, validation_loader, config)

model_artifact = wandb.Artifact(

"trained-model", type="model",

description="Trained NN model",

metadata=dict(model_config))

torch.save(model.state_dict(), "trained_model.pth")

model_artifact.add_file("trained_model.pth")

wandb.save("trained_model.pth")

run.log_artifact(model_artifact)

return model

def evaluate_and_log(config=None):

with wandb.init(project="artifacts-example", job_type="report", config=config) as run:

data = run.use_artifact('mnist-preprocess:latest')

data_dir = data.download()

testing_set = read(data_dir, "test")

test_loader = torch.utils.data.DataLoader(testing_set, batch_size=128, shuffle=False)

model_artifact = run.use_artifact("trained-model:latest")

model_dir = model_artifact.download()

model_path = os.path.join(model_dir, "trained_model.pth")

model_config = model_artifact.metadata

model = ConvNet(**model_config)

model.load_state_dict(torch.load(model_path))

model.to(device)

loss, accuracy, highest_losses, hardest_examples, true_labels, preds = evaluate(model, test_loader)

run.summary.update({"loss": loss, "accuracy": accuracy})

wandb.log({"high-loss-examples":

[wandb.Image(hard_example, caption=str(int(pred)) + "," + str(int(label)))

for hard_example, pred, label in zip(hardest_examples, preds, true_labels)]})

train_config = {"batch_size": 128,

"epochs": 5,

"batch_log_interval": 25,

"optimizer": "Adam"}

model = train_and_log(train_config)

evaluate_and_log()

5 - Programmatic Workspaces

Workspacesをプログラムで作成、管理、カスタマイズすることで、機械学習の実験をより効果的に整理し、可視化できます。設定を定義し、パネルレイアウトを設定し、

wandb-workspaces W&B ライブラリでセクションを整理できます。URLで

Workspacesをロードおよび変更したり、式を使用して

Runsをフィルタリングおよびグループ化したり、

Runsの外観をカスタマイズしたりできます。

wandb-workspacesは、W&BのWorkspacesとReportsをプログラムで作成およびカスタマイズするためのPythonライブラリです。

このチュートリアルでは、wandb-workspacesを使用して、設定を定義し、パネルレイアウトを設定し、セクションを整理することで、Workspacesを作成およびカスタマイズする方法を説明します。

ノートブックの使い方

- 各セルを一度に1つずつ実行します。

- セルを実行した後に表示されるURLをコピーして貼り付け、Workspaceに加えられた変更を表示します。

1. 依存関係のインストールとインポート

# 依存関係をインストールする

!pip install wandb wandb-workspaces rich

# 依存関係をインポートする

import os

import wandb

import wandb_workspaces.workspaces as ws

import wandb_workspaces.reports.v2 as wr # パネルを追加するためにReports APIを使用します

# 出力形式を改善する

%load_ext rich

このチュートリアルでは、wandb_workspaces APIを試すことができるように、新しいProjectを作成します。

注:一意のSaved view URLを使用して、既存のWorkspaceをロードできます。これを行う方法については、次のコードブロックを参照してください。

# Weights & Biasesを初期化してログインします

wandb.login()

# 新しいプロジェクトを作成し、サンプルデータを記録する関数

def create_project_and_log_data():

project = "workspace-api-example" # デフォルトのプロジェクト名

# サンプルデータを記録するためにrunを初期化します

with wandb.init(project=project, name="sample_run") as run:

for step in range(100):

wandb.log({

"Step": step,

"val_loss": 1.0 / (step + 1),

"val_accuracy": step / 100.0,

"train_loss": 1.0 / (step + 2),

"train_accuracy": step / 110.0,

"f1_score": step / 100.0,

"recall": step / 120.0,

})

return project

# 新しいプロジェクトを作成し、データを記録します

project = create_project_and_log_data()

entity = wandb.Api().default_entity

新しいProjectを作成する代わりに、独自の既存のProjectとWorkspaceをロードできます。これを行うには、一意のWorkspace URLを見つけて、文字列としてws.Workspace.from_urlに渡します。URLの形式はhttps://wandb.ai/[SOURCE-ENTITY]/[SOURCE-USER]?nw=abcです。

例:

wandb.login()

workspace = ws.Workspace.from_url("https://wandb.ai/[SOURCE-ENTITY]/[SOURCE-USER]?nw=abc").

workspace = ws.Workspace(

entity="NEW-ENTITY",

project=NEW-PROJECT,

name="NEW-SAVED-VIEW-NAME"

)

以下は、プログラムによるWorkspace機能を使用する例です。

# ワークスペース、セクション、およびパネルで利用可能なすべての設定を表示します。

all_settings_objects = [x for x in dir(ws) if isinstance(getattr(ws, x), type)]

all_settings_objects

この例では、新しいWorkspaceを作成し、セクションとパネルを入力する方法を示します。Workspacesは、通常のPythonオブジェクトのように編集でき、柔軟性と使いやすさを提供します。

def sample_workspace_saved_example(entity: str, project: str) -> str:

workspace: ws.Workspace = ws.Workspace(

name="Example W&B Workspace",

entity=entity,

project=project,

sections=[

ws.Section(

name="Validation Metrics",

panels=[

wr.LinePlot(x="Step", y=["val_loss"]),

wr.BarPlot(metrics=["val_accuracy"]),

wr.ScalarChart(metric="f1_score", groupby_aggfunc="mean"),

],

is_open=True,

),

],

)

workspace.save()

print("Sample Workspace saved.")

return workspace.url

workspace_url: str = sample_workspace_saved_example(entity, project)

元の設定に影響を与えることなく、Workspacesを複製してカスタマイズします。これを行うには、既存のWorkspaceをロードし、新しいビューとして保存します。

def save_new_workspace_view_example(url: str) -> None:

workspace: ws.Workspace = ws.Workspace.from_url(url)

workspace.name = "Updated Workspace Name"

workspace.save_as_new_view()

print(f"Workspace saved as new view.")

save_new_workspace_view_example(workspace_url)

Workspaceの名前が「Updated Workspace Name」になっていることに注意してください。

基本設定

次のコードは、Workspaceを作成し、パネル付きのセクションを追加し、Workspace、個々のセクション、およびパネルの設定を構成する方法を示しています。

# カスタム設定でワークスペースを作成および構成する関数

def custom_settings_example(entity: str, project: str) -> None:

workspace: ws.Workspace = ws.Workspace(name="An example workspace", entity=entity, project=project)

workspace.sections = [

ws.Section(

name="Validation",

panels=[

wr.LinePlot(x="Step", y=["val_loss"]),

wr.LinePlot(x="Step", y=["val_accuracy"]),

wr.ScalarChart(metric="f1_score", groupby_aggfunc="mean"),

wr.ScalarChart(metric="recall", groupby_aggfunc="mean"),

],

is_open=True,

),

ws.Section(

name="Training",

panels=[

wr.LinePlot(x="Step", y=["train_loss"]),

wr.LinePlot(x="Step", y=["train_accuracy"]),

],

is_open=False,

),

]

workspace.settings = ws.WorkspaceSettings(

x_axis="Step",

x_min=0,

x_max=75,

smoothing_type="gaussian",

smoothing_weight=20.0,

ignore_outliers=False,

remove_legends_from_panels=False,

tooltip_number_of_runs="default",

tooltip_color_run_names=True,

max_runs=20,

point_visualization_method="bucketing",

auto_expand_panel_search_results=False,

)

section = workspace.sections[0]

section.panel_settings = ws.SectionPanelSettings(

x_min=25,

x_max=50,

smoothing_type="none",

)

panel = section.panels[0]

panel.title = "Validation Loss Custom Title"

panel.title_x = "Custom x-axis title"

workspace.save()

print("Workspace with custom settings saved.")

# 関数を実行してワークスペースを作成および構成します

custom_settings_example(entity, project)

「An example workspace」という別の保存されたビューを表示していることに注意してください。

Runsをカスタマイズする

次のコードセルは、Runsをプログラムでフィルタリング、色の変更、グループ化、および並べ替える方法を示しています。

各例では、一般的なワークフローは、ws.RunsetSettingsの適切なパラメータへの引数として、目的のカスタマイズを指定することです。

Runsをフィルタリングする

Python式と、wandb.logで記録するメトリクス、またはCreated TimestampのようにRunの一部として自動的に記録されるメトリクスを使用してフィルタを作成できます。Name、Tags、またはIDなど、W&B App UIでの表示方法でフィルタを参照することもできます。

次の例は、検証損失の要約、検証精度の要約、および指定された正規表現に基づいてRunsをフィルタリングする方法を示しています。

def advanced_filter_example(entity: str, project: str) -> None:

# プロジェクト内のすべてのRunsを取得します

runs: list = wandb.Api().runs(f"{entity}/{project}")

# 複数のフィルタを適用します:val_loss < 0.1、val_accuracy > 0.8、およびrun名が正規表現パターンと一致します

workspace: ws.Workspace = ws.Workspace(

name="Advanced Filtered Workspace with Regex",

entity=entity,

project=project,

sections=[

ws.Section(

name="Advanced Filtered Section",

panels=[

wr.LinePlot(x="Step", y=["val_loss"]),

wr.LinePlot(x="Step", y=["val_accuracy"]),

],

is_open=True,

),

],

runset_settings=ws.RunsetSettings(

filters=[

(ws.Summary("val_loss") < 0.1), # 'val_loss'サマリーでRunsをフィルタリングします

(ws.Summary("val_accuracy") > 0.8), # 'val_accuracy'サマリーでRunsをフィルタリングします

(ws.Metric("ID").isin([run.id for run in wandb.Api().runs(f"{entity}/{project}")])),

],

regex_query=True,

)

)

# 's'で始まるrun名に一致するように正規表現検索を追加します

workspace.runset_settings.query = "^s"

workspace.runset_settings.regex_query = True

workspace.save()

print("Workspace with advanced filters and regex search saved.")

advanced_filter_example(entity, project)

フィルタ式のリストを渡すと、ブール値の「AND」ロジックが適用されることに注意してください。

この例では、WorkspaceでRunsの色を変更する方法を示します。

def run_color_example(entity: str, project: str) -> None:

# プロジェクト内のすべてのRunsを取得します

runs: list = wandb.Api().runs(f"{entity}/{project}")

# Runsに色を動的に割り当てます

run_colors: list = ['purple', 'orange', 'teal', 'magenta']

run_settings: dict = {}

for i, run in enumerate(runs):

run_settings[run.id] = ws.RunSettings(color=run_colors[i % len(run_colors)])

workspace: ws.Workspace = ws.Workspace(

name="Run Colors Workspace",

entity=entity,

project=project,

sections=[

ws.Section(

name="Run Colors Section",

panels=[

wr.LinePlot(x="Step", y=["val_loss"]),

wr.LinePlot(x="Step", y=["val_accuracy"]),

],

is_open=True,

),

],

runset_settings=ws.RunsetSettings(

run_settings=run_settings

)

)

workspace.save()

print("Workspace with run colors saved.")

run_color_example(entity, project)

この例では、特定のメトリクスでRunsをグループ化する方法を示します。

def grouping_example(entity: str, project: str) -> None:

workspace: ws.Workspace = ws.Workspace(

name="Grouped Runs Workspace",

entity=entity,

project=project,

sections=[

ws.Section(

name="Grouped Runs",

panels=[

wr.LinePlot(x="Step", y=["val_loss"]),

wr.LinePlot(x="Step", y=["val_accuracy"]),

],

is_open=True,

),

],

runset_settings=ws.RunsetSettings(

groupby=[ws.Metric("Name")]

)

)

workspace.save()

print("Workspace with grouped runs saved.")

grouping_example(entity, project)

この例では、検証損失の要約に基づいてRunsをソートする方法を示します。

def sorting_example(entity: str, project: str) -> None:

workspace: ws.Workspace = ws.Workspace(

name="Sorted Runs Workspace",

entity=entity,

project=project,

sections=[

ws.Section(

name="Sorted Runs",

panels=[

wr.LinePlot(x="Step", y=["val_loss"]),

wr.LinePlot(x="Step", y=["val_accuracy"]),

],

is_open=True,

),

],

runset_settings=ws.RunsetSettings(

order=[ws.Ordering(ws.Summary("val_loss"))] # val_lossサマリーを使用して順序付けます

)

)

workspace.save()

print("Workspace with sorted runs saved.")

sorting_example(entity, project)

4. すべてをまとめる:包括的な例

この例では、包括的なWorkspaceを作成し、その設定を構成し、セクションにパネルを追加する方法を示します。

def full_end_to_end_example(entity: str, project: str) -> None:

# プロジェクト内のすべてのRunsを取得します

runs: list = wandb.Api().runs(f"{entity}/{project}")

# Runsに色を動的に割り当て、run設定を作成します

run_colors: list = ['red', 'blue', 'green', 'orange', 'purple', 'teal', 'magenta', '#FAC13C']

run_settings: dict = {}

for i, run in enumerate(runs):

run_settings[run.id] = ws.RunSettings(color=run_colors[i % len(run_colors)], disabled=False)

workspace: ws.Workspace = ws.Workspace(

name="My Workspace Template",

entity=entity,

project=project,

sections=[

ws.Section(

name="Main Metrics",

panels=[

wr.LinePlot(x="Step", y=["val_loss"]),

wr.LinePlot(x="Step", y=["val_accuracy"]),

wr.ScalarChart(metric="f1_score", groupby_aggfunc="mean"),

],

is_open=True,

),

ws.Section(

name="Additional Metrics",

panels=[

wr.ScalarChart(metric="precision", groupby_aggfunc="mean"),

wr.ScalarChart(metric="recall", groupby_aggfunc="mean"),

],

),

],

settings=ws.WorkspaceSettings(

x_axis="Step",

x_min=0,

x_max=100,

smoothing_type="none",

smoothing_weight=0,

ignore_outliers=False,

remove_legends_from_panels=False,

tooltip_number_of_runs="default",

tooltip_color_run_names=True,

max_runs=20,

point_visualization_method="bucketing",

auto_expand_panel_search_results=False,

),

runset_settings=ws.RunsetSettings(

query="",

regex_query=False,

filters=[

ws.Summary("val_loss") < 1,

ws.Metric("Name") == "sample_run",

],

groupby=[ws.Metric("Name")],

order=[ws.Ordering(ws.Summary("Step"), ascending=True)],

run_settings=run_settings

)

)

workspace.save()

print("Workspace created and saved.")

full_end_to_end_example(entity, project)

6 - Integration tutorials

6.1 - PyTorch

Weights & Biases を使用して、 機械学習 の 実験管理 、 データセット の バージョン管理 、および プロジェクト の コラボレーションを行います。

この ノートブック の内容

この ノートブック では、 Weights & Biases を PyTorch コード に 統合して、 実験管理 を パイプライン に 追加する方法を紹介します。

# ライブラリをインポート

import wandb

# 新しい 実験 を開始

wandb.init(project="new-sota-model")

# config で ハイパーパラメーター の 辞書 をキャプチャ

wandb.config = {"learning_rate": 0.001, "epochs": 100, "batch_size": 128}

# モデル と データ をセットアップ

model, dataloader = get_model(), get_data()

# オプション: 勾配 を追跡

wandb.watch(model)

for batch in dataloader:

metrics = model.training_step()

# トレーニング ループ 内で メトリクス を ログ に記録して、 モデル の パフォーマンス を視覚化します。

wandb.log(metrics)

# オプション: 最後に モデル を保存

model.to_onnx()

wandb.save("model.onnx")

ビデオ チュートリアルをご覧ください。

注: Step で始まるセクションは、既存の パイプライン に W&B を 統合 するために必要なすべてです。残りの部分は、 データ を ロード し、 モデル を定義するだけです。

インストール、インポート、および ログイン

import os

import random

import numpy as np

import torch

import torch.nn as nn

import torchvision

import torchvision.transforms as transforms

from tqdm.auto import tqdm

# 決定論的な 振る舞い を確認

torch.backends.cudnn.deterministic = True

random.seed(hash("setting random seeds") % 2**32 - 1)

np.random.seed(hash("improves reproducibility") % 2**32 - 1)

torch.manual_seed(hash("by removing stochasticity") % 2**32 - 1)

torch.cuda.manual_seed_all(hash("so runs are repeatable") % 2**32 - 1)

# デバイス の 設定

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

# MNIST ミラー の リスト から 低速 ミラー を削除

torchvision.datasets.MNIST.mirrors = [mirror for mirror in torchvision.datasets.MNIST.mirrors

if not mirror.startswith("http://yann.lecun.com")]

Step 0: W&B の インストール

まず、 ライブラリ を取得する必要があります。

wandb は pip を使用して簡単に インストール できます。

!pip install wandb onnx -Uq

Step 1: W&B の インポート と ログイン

データ を Web サービス に ログ に記録するには、 ログイン する必要があります。

W&B を初めて使用する場合は、表示される リンク で 無料 アカウント にサインアップする必要があります。

import wandb

wandb.login()

実験 と パイプライン を定義

wandb.init を使用して メタデータ と ハイパーパラメーター を追跡

プログラムで、最初に行うことは 実験 を定義することです。

ハイパーパラメーター は何ですか? どのような メタデータ がこの run に 関連付けられていますか?

この 情報 を config 辞書 (または同様の オブジェクト ) に保存し、必要に応じて アクセス するのは非常に一般的な ワークフロー です。

この 例 では、いくつかの ハイパーパラメーター のみを変えることができ、残りは手動で コーディング しています。

ただし、 モデル の 任意の部分を config の一部にすることができます。

また、いくつかの メタデータ も含めます。MNIST データセット と 畳み込み アーキテクチャー を使用しています。たとえば、後で同じ プロジェクト で CIFAR 上の完全に接続された アーキテクチャー を使用する場合、これは run を分離するのに役立ちます。

config = dict(

epochs=5,

classes=10,

kernels=[16, 32],

batch_size=128,

learning_rate=0.005,

dataset="MNIST",

architecture="CNN")

次に、 モデル トレーニング に非常に一般的な 全体的な パイプライン を定義しましょう。

- まず、 モデル 、 関連 データ 、および オプティマイザー を

make し、次に

- モデル をそれに応じて

train し、最後に

test して、 トレーニング の 結果 を確認します。

これらの 関数 を以下に実装します。

def model_pipeline(hyperparameters):

# wandb に 開始 するように指示

with wandb.init(project="pytorch-demo", config=hyperparameters):

# wandb.config を介してすべての HPs に アクセス して、 ログ が 実行 と一致するようにします。

config = wandb.config

# モデル 、 データ 、および 最適化 の 問題 を作成

model, train_loader, test_loader, criterion, optimizer = make(config)

print(model)

# それらを使用して モデル を トレーニング

train(model, train_loader, criterion, optimizer, config)

# 最終的な パフォーマンス を テスト

test(model, test_loader)

return model

標準的な パイプライン との唯一の違いは、それがすべて wandb.init の コンテキスト 内で発生することです。

この 関数 を 呼び出すと、 コード と サーバー 間の 通信回線 が 設定 されます。

config 辞書 を wandb.init に 渡すと、その 情報 がすべてすぐに ログ に記録されるため、 実験 で使用するように 設定 した ハイパーパラメーター の 値 を常に把握できます。

選択および ログ に記録した 値 が モデル で常に使用されるようにするために、 オブジェクト の wandb.config コピー を使用することをお勧めします。

いくつかの 例 を 参照 するには、以下の make の 定義 を確認してください。

サイド ノート: コード を 個別の プロセス で 実行 するように注意してください。これにより、こちら側の 問題 (巨大な海の モンスター が データセンター を攻撃するなど) によって コード が クラッシュ しないようにします。

クラーケン が 深海 に戻るなど、 問題 が解決されたら、 wandb sync で データ を ログ に記録できます。

def make(config):

# データ を作成

train, test = get_data(train=True), get_data(train=False)

train_loader = make_loader(train, batch_size=config.batch_size)

test_loader = make_loader(test, batch_size=config.batch_size)

# モデル を作成

model = ConvNet(config.kernels, config.classes).to(device)

# 損失 と オプティマイザー を作成

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(

model.parameters(), lr=config.learning_rate)

return model, train_loader, test_loader, criterion, optimizer

データ の ロード と モデル を定義

次に、 データ の ロード 方法と モデル の 外観を指定する必要があります。

この部分は非常に重要ですが、wandb がなくても同じであるため、詳しく説明しません。

def get_data(slice=5, train=True):

full_dataset = torchvision.datasets.MNIST(root=".",

train=train,

transform=transforms.ToTensor(),

download=True)

# [::slice] で スライス するのと同等

sub_dataset = torch.utils.data.Subset(

full_dataset, indices=range(0, len(full_dataset), slice))

return sub_dataset

def make_loader(dataset, batch_size):

loader = torch.utils.data.DataLoader(dataset=dataset,

batch_size=batch_size,

shuffle=True,

pin_memory=True, num_workers=2)

return loader

モデル を定義するのは通常楽しい部分です。

しかし、wandb では何も変わらないため、 標準的な ConvNet アーキテクチャー を使用します。

これをいじって 実験 を試すことを恐れないでください。すべての 結果 は wandb.ai に ログ 記録されます。

# 従来の畳み込み ニューラルネットワーク

class ConvNet(nn.Module):

def __init__(self, kernels, classes=10):

super(ConvNet, self).__init__()

self.layer1 = nn.Sequential(

nn.Conv2d(1, kernels[0], kernel_size=5, stride=1, padding=2),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2))

self.layer2 = nn.Sequential(

nn.Conv2d(16, kernels[1], kernel_size=5, stride=1, padding=2),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2))

self.fc = nn.Linear(7 * 7 * kernels[-1], classes)

def forward(self, x):

out = self.layer1(x)

out = self.layer2(out)

out = out.reshape(out.size(0), -1)

out = self.fc(out)

return out

トレーニング ロジック を定義

model_pipeline で 進めて、train 方法を指定します。

ここでは、2 つの wandb 関数 が 役立ちます。watch と log です。

wandb.watch で 勾配 を追跡し、wandb.log で その他 すべてを追跡

wandb.watch は、 トレーニング のすべての log_freq ステップ で、 モデル の 勾配 と パラメータ を ログ に記録します。

必要なのは、 トレーニング を開始する前にそれを 呼び出すことだけです。

残りの トレーニング コード は同じままです。 エポック と バッチ を 反復処理し、 forward pass と backward pass を 実行 し、オプティマイザー を 適用 します。

def train(model, loader, criterion, optimizer, config):

# モデル が 実行 する 内容 ( 勾配 、 重み など) を wandb に 監視 させる。

wandb.watch(model, criterion, log="all", log_freq=10)

# トレーニング を 実行 し、wandb で 追跡

total_batches = len(loader) * config.epochs

example_ct = 0 # 確認された 例 の 数

batch_ct = 0

for epoch in tqdm(range(config.epochs)):

for _, (images, labels) in enumerate(loader):

loss = train_batch(images, labels, model, optimizer, criterion)

example_ct += len(images)

batch_ct += 1

# 25 回目の バッチ ごとに メトリクス を レポート

if ((batch_ct + 1) % 25) == 0:

train_log(loss, example_ct, epoch)

def train_batch(images, labels, model, optimizer, criterion):

images, labels = images.to(device), labels.to(device)

# Forward pass ➡

outputs = model(images)

loss = criterion(outputs, labels)

# Backward pass ⬅

optimizer.zero_grad()

loss.backward()

# オプティマイザー で ステップ

optimizer.step()

return loss

唯一の違いは ログ コード にあります。以前は ターミナル に 出力 して メトリクス を レポート していた可能性がありますが、 同じ 情報 を wandb.log に 渡すようになりました。

wandb.log は、 キー として 文字列 を持つ 辞書 を想定しています。これらの 文字列 は、 ログ に記録される オブジェクト を識別します。これらが 値 を 構成します。オプションで、 トレーニング のどの step にいるかを ログ に記録することもできます。

サイド ノート: バッチサイズ 全体で 比較 しやすくするために、 モデル が 確認 した 例 の 数を 使用するのが好きですが、 生の ステップ または バッチ カウント を使用できます。より 長い トレーニング run の 場合、エポック ごとに ログ に記録することも 理にかなっています。

def train_log(loss, example_ct, epoch):

# 魔法が起こる場所

wandb.log({"epoch": epoch, "loss": loss}, step=example_ct)

print(f"Loss after {str(example_ct).zfill(5)} examples: {loss:.3f}")

テスト ロジック を定義

モデル の トレーニング が完了したら、それを テスト します。たとえば、 プロダクション からの 新鮮な データ に対して 実行 したり、手作業で キュレーション された 例 に 適用 したりします。

(オプション) wandb.save を 呼び出す

これは、 モデル の アーキテクチャー と 最終的な パラメータ を ディスク に保存する絶好の機会でもあります。最大限の 互換性を得るために、Open Neural Network eXchange (ONNX) 形式で モデル を エクスポート します。

その ファイル名 を wandb.save に 渡すと、 モデル の パラメータ が W&B の サーバー に 保存されます。どの .h5 または .pb がどの トレーニング run に 対応 するかを 追跡 できなくなることはありません。

モデル を保存、 バージョン管理 、および 配布 するための、より 高度な wandb 機能 については、Artifacts ツールを ご覧ください。

def test(model, test_loader):

model.eval()

# いくつかの テスト 例 で モデル を 実行

with torch.no_grad():

correct, total = 0, 0

for images, labels in test_loader:

images, labels = images.to(device), labels.to(device)

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f"Accuracy of the model on the {total} " +

f"test images: {correct / total:%}")

wandb.log({"test_accuracy": correct / total})

# 交換可能な ONNX 形式 で モデル を保存

torch.onnx.export(model, images, "model.onnx")

wandb.save("model.onnx")

トレーニング を 実行 し、wandb.ai で メトリクス を ライブ で 監視

パイプライン 全体を定義し、いくつかの W&B コード を 挿入 したので、完全に 追跡 された 実験 を 実行 する 準備ができました。

ドキュメント、 プロジェクト ページ ( プロジェクト 内のすべての run を 整理します)、および この run の 結果 が 保存される Run ページへの リンク がいくつか レポート されます。

Run ページに 移動 し、これらの タブ を 確認 してください。

- Charts: トレーニング 全体で モデル の 勾配 、 パラメータ 値、および 損失 が ログ に記録されます。

- System: ディスク I/O 使用率、 CPU および GPU メトリクス (温度が急上昇するのを 監視 します) などの さまざまな システム メトリクス が含まれています。

- Logs: トレーニング 中に 標準出力 に プッシュ されたすべてのものの コピー があります。

- Files: トレーニング が完了すると、

model.onnx を クリック して、Netron モデル ビューアーで ネットワーク を 表示 できます。

run が 終了 すると、with wandb.init ブロック が 終了 するときに、 セル の 出力 に 結果 の 概要 も 出力 されます。

# パイプライン を使用して モデル を 構築、 トレーニング 、および 分析

model = model_pipeline(config)

Sweeps で ハイパーパラメーター を テスト

この 例 では、単一の ハイパーパラメーター セット のみを調べました。

しかし、ほとんどの ML ワークフロー の 重要な部分は、多くの ハイパーパラメーター を 反復処理することです。

Weights & Biases Sweeps を使用すると、 ハイパーパラメーター の テスト を 自動化し、 可能な モデル と 最適化 戦略 の スペース を 探索 できます。

Weights & Biases で ハイパーパラメーター sweep を 実行 するのは非常に簡単です。簡単な 3 つの ステップ があります。

-

sweep を定義: 検索 する パラメータ 、 検索 戦略、 最適化 メトリクス などを 指定する 辞書 または YAML ファイル を 作成 して、これを行います。

-

sweep を 初期化:

sweep_id = wandb.sweep(sweep_config)

-

sweep agent を 実行:

wandb.agent(sweep_id, function=train)

これで、 ハイパーパラメーター sweep の 実行 はすべて完了です。

例 ギャラリー

ギャラリー →で W&B で 追跡 および 視覚化 された プロジェクト の 例 を ご覧ください

高度な 設定

- 環境変数: 管理対象 クラスター で トレーニング を 実行 できるように、 環境変数 で APIキー を 設定 します。

- オフライン モード:

dryrun モード を 使用 して オフライン で トレーニング し、後で 結果 を 同期 します。

- オンプレミス: プライベートクラウド または お客様の インフラストラクチャー 内の エアギャップ サーバー に W&B を インストール します。 学術関係者から エンタープライズ チーム まで、あらゆる ユーザー 向けの ローカル インストール があります。

- Sweeps: チューニング 用の 軽量 ツール を 使用 して、 ハイパーパラメーター 検索 を 迅速に 設定 します。

6.2 - PyTorch Lightning

PyTorch Lightning を使用して画像分類のパイプラインを構築します。コードの可読性と再現性を高めるために、こちらの

スタイル ガイド に従います。これに関するわかりやすい説明は、

こちらにあります。

PyTorch Lightning と W&B のセットアップ

このチュートリアルでは、PyTorch Lightning と Weights & Biases が必要です。

pip install lightning -q

pip install wandb -qU

import lightning.pytorch as pl

# お気に入りの 機械学習 トラッキング ツール

from lightning.pytorch.loggers import WandbLogger

import torch

from torch import nn

from torch.nn import functional as F

from torch.utils.data import random_split, DataLoader

from torchmetrics import Accuracy

from torchvision import transforms

from torchvision.datasets import CIFAR10

import wandb

次に、wandb アカウントにログインする必要があります。

wandb.login()

DataModule - 価値のあるデータ パイプライン

DataModule は、データ関連のフックを LightningModule から分離して、データセットに依存しないモデルを開発できるようにする方法です。

データパイプラインを 1 つの共有可能で再利用可能なクラスにまとめます。 datamodule は、PyTorch でのデータ処理に関わる次の 5 つのステップをカプセル化します。

- ダウンロード/トークン化/プロセッシング。

- クリーンアップして、(場合によっては)ディスクに保存します。

- データセット内にロードします。

- 変換(回転、トークン化など)を適用します。

- DataLoader 内にラップします。

datamodule の詳細については、こちらをご覧ください。 Cifar-10 データセット用の datamodule を構築してみましょう。

class CIFAR10DataModule(pl.LightningDataModule):

def __init__(self, batch_size, data_dir: str = './'):

super().__init__()

self.data_dir = data_dir

self.batch_size = batch_size

self.transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))

])

self.num_classes = 10

def prepare_data(self):

CIFAR10(self.data_dir, train=True, download=True)

CIFAR10(self.data_dir, train=False, download=True)

def setup(self, stage=None):

# dataloader で使用するトレーニング/検証データセットを割り当てます

if stage == 'fit' or stage is None:

cifar_full = CIFAR10(self.data_dir, train=True, transform=self.transform)

self.cifar_train, self.cifar_val = random_split(cifar_full, [45000, 5000])

# dataloader で使用するテストデータセットを割り当てます

if stage == 'test' or stage is None:

self.cifar_test = CIFAR10(self.data_dir, train=False, transform=self.transform)

def train_dataloader(self):

return DataLoader(self.cifar_train, batch_size=self.batch_size, shuffle=True)

def val_dataloader(self):

return DataLoader(self.cifar_val, batch_size=self.batch_size)

def test_dataloader(self):

return DataLoader(self.cifar_test, batch_size=self.batch_size)

コールバック

callback は、プロジェクト間で再利用できる自己完結型のプログラムです。 PyTorch Lightning には、定期的に使用されるいくつかの 組み込み callbacksが付属しています。

PyTorch Lightning の callbacks の詳細については、こちらをご覧ください。

組み込み Callbacks

このチュートリアルでは、組み込みの Early Stopping と Model Checkpoint の callbacks を使用します。 これらは Trainer に渡すことができます。

カスタム Callbacks

カスタム Keras callback に慣れている場合は、PyTorch パイプラインで同じことができる機能は、まさに嬉しいおまけです。

画像分類を実行しているので、モデルの予測をいくつかの画像のサンプルで視覚化できると役立ちます。 これを callback の形式にすることで、初期段階でモデルをデバッグできます。

class ImagePredictionLogger(pl.callbacks.Callback):

def __init__(self, val_samples, num_samples=32):

super().__init__()

self.num_samples = num_samples

self.val_imgs, self.val_labels = val_samples

def on_validation_epoch_end(self, trainer, pl_module):

# テンソルを CPU に取り込みます

val_imgs = self.val_imgs.to(device=pl_module.device)

val_labels = self.val_labels.to(device=pl_module.device)

# モデルの予測を取得します

logits = pl_module(val_imgs)

preds = torch.argmax(logits, -1)

# 画像を wandb Image として記録します

trainer.logger.experiment.log({

"examples":[wandb.Image(x, caption=f"Pred:{pred}, Label:{y}")

for x, pred, y in zip(val_imgs[:self.num_samples],

preds[:self.num_samples],

val_labels[:self.num_samples])]

})

LightningModule - システムの定義

LightningModule は、モデルではなくシステムを定義します。 ここでは、システムはすべての研究コードを 1 つのクラスにグループ化して、自己完結型にします。 LightningModule は、PyTorch コードを次の 5 つのセクションに整理します。

- 計算 (

__init__)。

- トレーニング ループ (

training_step)

- 検証ループ (

validation_step)

- テスト ループ (

test_step)

- オプティマイザー (

configure_optimizers)

したがって、簡単に共有できるデータセットに依存しないモデルを構築できます。 Cifar-10 分類用のシステムを構築してみましょう。

class LitModel(pl.LightningModule):

def __init__(self, input_shape, num_classes, learning_rate=2e-4):

super().__init__()

# ハイパーパラメータを記録します

self.save_hyperparameters()

self.learning_rate = learning_rate

self.conv1 = nn.Conv2d(3, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 32, 3, 1)

self.conv3 = nn.Conv2d(32, 64, 3, 1)

self.conv4 = nn.Conv2d(64, 64, 3, 1)

self.pool1 = torch.nn.MaxPool2d(2)

self.pool2 = torch.nn.MaxPool2d(2)

n_sizes = self._get_conv_output(input_shape)

self.fc1 = nn.Linear(n_sizes, 512)

self.fc2 = nn.Linear(512, 128)

self.fc3 = nn.Linear(128, num_classes)

self.accuracy = Accuracy(task='multiclass', num_classes=num_classes)

# conv ブロックから Linear レイヤーに入る出力テンソルのサイズを返します。

def _get_conv_output(self, shape):

batch_size = 1

input = torch.autograd.Variable(torch.rand(batch_size, *shape))

output_feat = self._forward_features(input)

n_size = output_feat.data.view(batch_size, -1).size(1)

return n_size

# conv ブロックから特徴テンソルを返します

def _forward_features(self, x):

x = F.relu(self.conv1(x))

x = self.pool1(F.relu(self.conv2(x)))

x = F.relu(self.conv3(x))

x = self.pool2(F.relu(self.conv4(x)))

return x

# 推論中に使用されます

def forward(self, x):

x = self._forward_features(x)

x = x.view(x.size(0), -1)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = F.log_softmax(self.fc3(x), dim=1)

return x

def training_step(self, batch, batch_idx):

x, y = batch

logits = self(x)

loss = F.nll_loss(logits, y)

# トレーニング メトリクス

preds = torch.argmax(logits, dim=1)

acc = self.accuracy(preds, y)

self.log('train_loss', loss, on_step=True, on_epoch=True, logger=True)

self.log('train_acc', acc, on_step=True, on_epoch=True, logger=True)

return loss

def validation_step(self, batch, batch_idx):

x, y = batch

logits = self(x)

loss = F.nll_loss(logits, y)

# 検証メトリクス

preds = torch.argmax(logits, dim=1)

acc = self.accuracy(preds, y)

self.log('val_loss', loss, prog_bar=True)

self.log('val_acc', acc, prog_bar=True)

return loss

def test_step(self, batch, batch_idx):

x, y = batch

logits = self(x)

loss = F.nll_loss(logits, y)

# 検証メトリクス

preds = torch.argmax(logits, dim=1)

acc = self.accuracy(preds, y)

self.log('test_loss', loss, prog_bar=True)

self.log('test_acc', acc, prog_bar=True)

return loss

def configure_optimizers(self):

optimizer = torch.optim.Adam(self.parameters(), lr=self.learning_rate)

return optimizer

トレーニングと評価

DataModule を使用してデータパイプラインを整理し、LightningModule を使用してモデル アーキテクチャ + トレーニング ループを整理したので、PyTorch Lightning Trainer がそれ以外のすべてを自動化します。

Trainer は以下を自動化します。

- エポックとバッチの反復

optimizer.step()、backward、zero_grad() の呼び出し.eval() の呼び出し、grads の有効化/無効化- 重みの保存とロード

- Weights & Biases ロギング

- 複数 GPU トレーニングのサポート

- TPU サポート

- 16 ビット トレーニングのサポート

dm = CIFAR10DataModule(batch_size=32)

# x_dataloader にアクセスするには、prepare_data と setup を呼び出す必要があります。

dm.prepare_data()

dm.setup()

# 画像予測を記録するためにカスタム ImagePredictionLogger callback で必要なサンプル。

val_samples = next(iter(dm.val_dataloader()))

val_imgs, val_labels = val_samples[0], val_samples[1]

val_imgs.shape, val_labels.shape

model = LitModel((3, 32, 32), dm.num_classes)

# wandb logger を初期化します

wandb_logger = WandbLogger(project='wandb-lightning', job_type='train')

# Callbacks を初期化します

early_stop_callback = pl.callbacks.EarlyStopping(monitor="val_loss")

checkpoint_callback = pl.callbacks.ModelCheckpoint()

# trainer を初期化します

trainer = pl.Trainer(max_epochs=2,

logger=wandb_logger,

callbacks=[early_stop_callback,

ImagePredictionLogger(val_samples),

checkpoint_callback],

)

# モデルをトレーニングします

trainer.fit(model, dm)

# ⚡⚡ 保持されたテスト セットでモデルを評価します

trainer.test(dataloaders=dm.test_dataloader())

# wandb run を閉じます

wandb.finish()

最終的な考え

私は TensorFlow/Keras エコシステム出身で、PyTorch はエレガントなフレームワークですが、少し圧倒されると感じています。 これはあくまで私の個人的な経験です。 PyTorch Lightning を調べているうちに、PyTorch から遠ざかっていた理由のほとんどが解消されていることに気づきました。 私が興奮している点の簡単なまとめを以下に示します。

- 以前: 従来の PyTorch モデルの定義は、あちこちに散らばっていました。 モデルは

model.py スクリプトに、トレーニング ループは train.py ファイルに記述されていました。 パイプラインを理解するには、何度も見返す必要がありました。

- 現在:

LightningModule は、モデルが training_step、validation_step などと共に定義されているシステムとして機能します。 これで、モジュール式になり、共有できるようになりました。

- 以前: TensorFlow/Keras の最も優れている点は、入力データ パイプラインです。 データセット カタログは豊富で、成長を続けています。 PyTorch のデータ パイプラインは、これまでで最大の難点でした。 通常の PyTorch コードでは、データのダウンロード/クリーンアップ/準備は通常、多くのファイルに分散しています。

- 現在: DataModule は、データ パイプラインを 1 つの共有可能で再利用可能なクラスにまとめます。 これは単に、

train_dataloader、val_dataloader(s)、test_dataloader(s) のコレクションであり、必要な変換とデータ プロセッシング/ダウンロードの手順が付属しています。

- 以前: Keras を使用すると、

model.fit を呼び出してモデルをトレーニングし、model.predict を呼び出して推論を実行できます。 model.evaluate は、テストデータに対する古き良き単純な評価を提供しました。 これは PyTorch には当てはまりません。 通常、個別の train.py ファイルと test.py ファイルが見つかります。

- 現在:

LightningModule が導入されたことで、Trainer がすべてを自動化します。 モデルをトレーニングおよび評価するには、trainer.fit と trainer.test を呼び出すだけで済みます。

- 以前: TensorFlow は TPU が大好きですが、PyTorch は…

- 現在: PyTorch Lightning を使用すると、複数の GPU や TPU 上でも同じモデルを簡単にトレーニングできます。

- 以前: 私は Callbacks の大ファンで、カスタム callbacks を記述することを好みます。 Early Stopping のように些細なことでも、従来の PyTorch では議論の対象となっていました。

- 現在: PyTorch Lightning を使用すると、Early Stopping と Model Checkpointing を簡単に使用できます。 カスタム callbacks を記述することもできます。

🎨 まとめとリソース

このレポートがお役に立てば幸いです。 コードを試して、選択したデータセットを使用して画像分類器をトレーニングすることをお勧めします。

PyTorch Lightning の詳細については、次のリソースをご覧ください。

6.3 - Hugging Face

Hugging Face

Hugging Face モデルのパフォーマンスを、シームレスな

W&B インテグレーションで素早く可視化しましょう。

モデル間で、ハイパーパラメーター、出力メトリクス、 GPU 使用率などのシステム統計を比較します。

W&B を使うべき理由

- 統合ダッシュボード : すべてのモデルメトリクスと予測の一元的なリポジトリ

- 軽量 : Hugging Face と統合するために必要なコード変更はありません

- アクセス可能 : 個人およびアカデミックチームは無料

- セキュア : デフォルトでは、すべての Projects がプライベートです

- 信頼性 : OpenAI、トヨタ、Lyft などの機械学習チームで使用されています

W&B は、機械学習モデルの GitHub のようなものだと考えてください。機械学習の Experiments をプライベートなホストされたダッシュボードに保存します。スクリプトをどこで実行していても、すべてのバージョンのモデルが保存されるので、安心して迅速に Experiments を行うことができます。

W&B の軽量インテグレーションは、あらゆる Python スクリプトで動作し、モデルのトラッキングと可視化を開始するには、無料の W&B アカウントにサインアップするだけです。

Hugging Face Transformers リポジトリでは、 Trainer に、トレーニングおよび評価メトリクスを各ロギングステップで W&B に自動的にログ記録するように設定しました。

インテグレーションの仕組みの詳細はこちら: Hugging Face + W&B Report。

インストール、インポート、ログイン

Hugging Face と Weights & Biases のライブラリ、およびこのチュートリアルの GLUE データセットとトレーニングスクリプトをインストールします。

!pip install datasets wandb evaluate accelerate -qU

!wget https://raw.githubusercontent.com/huggingface/transformers/refs/heads/main/examples/pytorch/text-classification/run_glue.py

# run_glue.py スクリプトには transformers dev が必要です